linux服务器连接不上huggingface的解决办法(以及本地下载huggingface模型流程)

- 本地下载huggingface模型的办法

-

- 方法一:使用huggingface_hub库下载

-

- 离线加载模型

- 方法二:使用transformers库下载(需要安装pytorch库)

-

- 离线加载模型

- 方法三: 使用git工具下载(但需要在git里设置代理)

- 方法四:需要代理(使用huggingface-cli工具)

- 加载本地下载模型的方法:

-

- 1. 模型存放路径的选择

- 2. 项目文件结构示例

- 3. 如何在代码中加载本地模型

-

- 重点解释:

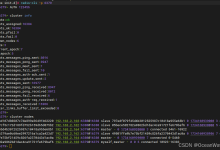

- 找到本地下载huggingface模型的服务器默认路径的方法

- 最后的碎碎念

本地下载huggingface模型的办法

方法一:使用huggingface_hub库下载

先安装huggingface_hub库:

pip install huggingface_hub

之后运行:

from huggingface_hub import snapshot_download

# 指定模型名称和下载路径

model_name = \”bert-base-uncased\”

save_path = \”./my_local_model\”

# 下载模型

snapshot_download(repo_id=model_name, cache_dir=save_path)

但是注意,因为网络问题,需要科学上网才能下载下来.

但是我们可以使用镜像网站,不需要科学上网就能直接下载。

import os

os.environ[\’HF_ENDPOINT\’] = \’https://hf-mirror.com\’ # 这个镜像网站可能也可以换掉

from huggingface_hub import snapshot_download

snapshot_download(repo_id=\”google-bert/bert-base-uncased\”,

local_dir_use_symlinks=False,

local_dir=\”./google-bert/bert-base-uncased\”)

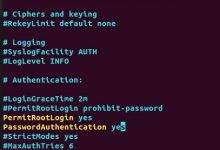

离线加载模型

如果你已经下载好了模型,并且希望之后在离线环境中使用这些模型,你可以通过local_files_only=True参数来确保模型从本地加载,而不是重新联网下载。

model = AutoModel.from_pretrained(model_save_path, local_files_only=True)

tokenizer = AutoTokenizer.from_pretrained(model_save_path, local_files_only=True)

方法二:使用transformers库下载(需要安装pytorch库)

- 首先需要安装好pytorch库(AutoModelForSequenceClassification这个类是基于PyTorch的一个库)

- 其次需要安装好Hugging Face 的 transformers 库以及 huggingface_hub 库。这两个库可以通过 pip 安装:

pip install transformers

pip install huggingface_hub

如果你使用的是Windows和pip,没有合适的GPU,可以安装CPU版本的PyTorch,可以使用以下命令:

pip install torch torchvision torchaudio

pip install transformers

from transformers import AutoTokenizer, AutoModelForSequenceClassification

# 下载模型和分词器

model_name = \”bert-base-uncased\”

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForSequenceClassification.from_pretrained(model_name)

# 保存模型到本地

model.save_pretrained(\”./models/bert-base-uncased\”)

tokenizer

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册