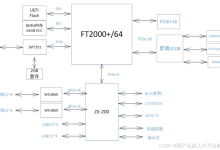

AI服务器的系统架构较为复杂且多样化。AI服务器通常采用异构架构进行加速计算,常采用 CPU+GPU、CPU+FPGA、CPU+ASIC 等多种形式。其面向深度学习神经网络需要的快速、低精度、浮点运算高度并行数值计算,搭载大量计算内核和高带宽内存资源。

从产业链角度看,AI服务器的主要构成包括芯片(如 CPU、GPU、FPGA、ASIC 和 NPU)、内存(DRAM、HBM)、本地存储(SSD)、其他组件(NIC、PCIe 插槽、散热系统等)。

AI服务器是人工智能基础层的核心物理设备,为人工智能应用提供强大的计算支持。在架构形式上,AI服务器采用 CPU+加速芯片的组合,使得模型训练和推断更具效率优势。例如,根据 GPU 的数量,AI服务器可分为四路、八路和十六路服务器,其中八路 AI 服务器,搭载 8 块 GPU,最为常见。传统服务器的 DRAM 容量一般为 500 – 600GB,而 AI 服务器的平均内存容量则达到了 1.2 – 1.7TB,远超传统服务器。

AI 服务器架构类型有很多种,常见的包括 CPU 架构、GPU 架构、FPGA 架构、ASIC 架构、TPU 架构以及混合架构。CPU 架构的 AI 服务器主要依赖于 CPU 进行计算,具有较高的通用性,但在处理大规模并行计算时性能可能不如 GPU 架构的服务器。GPU 架构的 AI 服务器具有较高的并行计算能力,通常用于深度学习、图像识别等需要大量并行计算的人工智能应用。FPGA 架构的 AI 服务器具有较高的灵活性和可定制性,可以针对特定的人工智能应用进行优化。ASIC 架构的 AI 服务器具有较高的性能和能效比,但灵活性较低。TPU 架构的 AI 服务器主要依赖于 TPU 进行计算,具有高性能和低功耗的特点,通常用于谷歌的 TensorFlow 框架。混合架构的 AI 服务器结合了多种架构的优点,可以提供更高的性能和灵活性。

AI 服务器异构架构形式有哪些

AI 服务器主要采用异构形式,表现形态多为机架式。异构方式有 CPU+GPU、CPU+FPGA、CPU+TPU、CPU+ASIC 或 CPU+多种加速卡等。目前广泛使用的是 CPU+GPU 的形式。这种异构架构能够满足不同人工智能应用的需求。例如,在图像识别任务中,GPU 的并行计算能力可以快速处理大量图像数据,而 CPU 则负责任务调度和部分计算工作。CPU 为通用型处理器,采用串行架构,擅长逻辑计算;GPU 采用并行计算模式,单卡核心数达到上千个,擅长处理密集型运算应用,如图形渲染、计算视觉和机器学习。FPGA 可编程逻辑阵列,适合定制化计算需求;ASIC 专用集成电路,高效能,适合特定 AI 应用;TPU 优化机器学习任务,高性能神经网络计算;NPU 神经网络处理器,擅长深度学习任务。不同的异构架构可

网硕互联帮助中心

网硕互联帮助中心

![[已解决·实验日志] AutoDL系统盘异常爆满,原因是PyCharm 在连接到远程服务器调试时,自动执行后台任务(正在更新 python解释器), 将某些包&依赖项下载到了服务器上-网硕互联帮助中心](https://www.wsisp.com/helps/wp-content/uploads/2025/04/20250419204602-68040b8ac23b2-220x150.png)

评论前必须登录!

注册