目录

一、环境准备

1.1 创建AutoDL实例

1.2 基础环境配置

二、模型下载与准备

2.1 下载Qwen2.5-Omni模型

2.2 模型量化(可选)

三、vLLM API服务部署

3.1 启动API服务

3.2 持久化运行(使用tmux)

四、配置外部访问

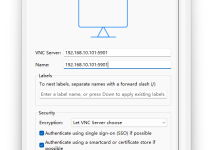

4.1 AutoDL端口映射

4.2 Nginx反向代理(推荐)

4.3 配置安全组规则

五、外部服务器访问测试

5.1 获取AutoDL实例访问地址

5.2 测试API连接

5.3 添加API密钥认证(可选)

六、性能优化建议

6.1 监控GPU状态

6.2 调整批处理参数

6.3 启用连续批处理

七、常见问题解决

八、成本估算(AutoDL)

本文将详细介绍如何在AutoDL云计算平台上使用vLLM部署Qwen2.5-Omni大语言模型,并配置允许从外部服务器访问的API服务。本方案结合了AutoDL的高性价比GPU资源和vLLM的高效推理能力,适合需要对外提供大模型服务的中小企业和开发者。

一、环境准备

1.1 创建AutoDL实例

-

- GPU型号:至少RTX 3090(24GB)或A100(40GB/80GB)

- 镜像选择:PyTorch 2.1.0系列(已预装CUDA 11.8)

- 系统盘:100GB(模型约50GB)

- 数据盘:可选挂载(如需持久化存储)

1.2 基础环境配置

# 连接实例后执行

# 1. 更新系统包

apt-get update && apt-get upgrade -y

# 2. 安装必要工具

apt-get install -y git-lfs nginx

# 3. 配置Python环境

conda create -n qwen python=3.10 -y

conda activate qwen

pip install vllm==0.4.1 transformers==4.40.0

二、模型下载与准备

2.1 下载Qwen2.5-Omni模型

# 推荐使用modelscope下载(国内速度更快)

pip install modelscope

python -c \”from modelscope import snapshot_download; snapshot_download(\’qwen/Qwen2.5-Omni\’, cache_dir=\’/root/autodl-tmp/Qwen2.5-Omni\’)\”

# 或者使用HuggingFace(需配置代理)

huggingface-cli download Qwen/Qwen2.5-Omni –local-dir /root/autodl-tmp/Qwen2.5-Omni

2.2 模型量化(可选)

为减少显存占用,可使用AWQ量化:

pip install autoawq

python -m awq.entrypoint \\

–model_path /root/autodl-tmp/Qwen2.5-Omni \\

–output_path /root/autodl-tmp/Qwen2.5-Omni-AWQ \\

–w_bit 4 –q_group_size 128

三、vLLM API服务部署

3.1 启动API服务

# 基础启动命令(单GPU)

python -m

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册