概要

` 使用LLamaFactory微调大模型时,很多依赖的版本关系复杂,很容易出现版本冲突的问题,这里主要涉及到cuda/pytorch/python/auto-gptq/vllm/版本的选择,我在查看了很多博客和技术资料后在autoDl上进行多个版本的组合实验,特此记录一下

一、硬件配置

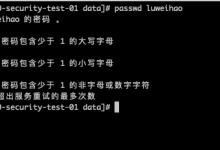

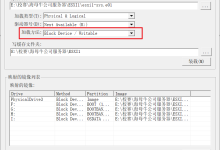

采用租用云算力服务器方式:由于是基于大于1B的大模型需要硬件配置较高,租用算力服务器比如AutoDL算力云一小时也就1-2元左右,主要是图方便,当然也比自购显卡省钱.关于购买云服务网上较多教程,也不复杂,可自行购买不过每次记得要人走关机,不然会继续扣费 AutoDL服务器租用的时候一定要点\”查看详情\”查看一下红框内的参数选择,参数务必严格选择,若不一样一定要点击\”更换\”使之一样(这很重要!否则后续会很麻烦). 我选择的是:RTX4090 ,PyTorch 2.1.0 ,Python 3.10(ubuntu22.04) ,Cuda 12.1 ` 提示:这里尽量选RTX4090的显卡,同样的版本我在RTX的RTX3080显卡上还是会出现版本不兼容的问题:为此我特地查了一下两个显卡的架构,RTX4090的架构采用了Ampere架构,而采用的是RTX3080Turing架构

二、环境配置

` 环境配置很容易出现各种版本冲突,以下是已验证的(高,低)两种组合,可以按需要取其一安装.

高配组合:尽量往高版本靠,忽略官方要求.能正常运行(推荐安装).

> 版本组合:cuda12.4/pytorch2

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册