2025年1月下旬,DeepSeek的R1模型发布后的一周内就火了,性能比肩OpenAI的o1模型,且训练成本仅为560万美元,成本远低于openAI,使得英伟达股票大跌。

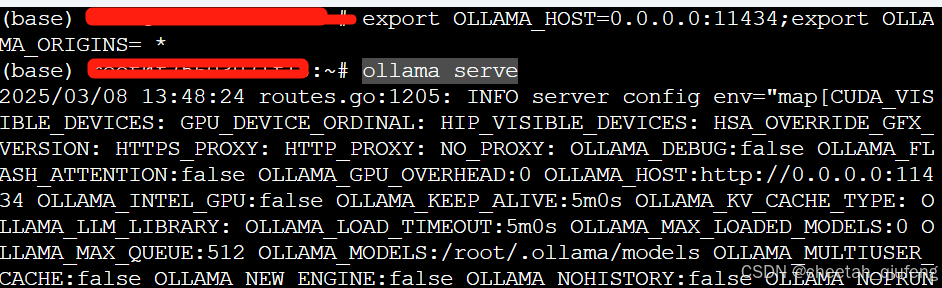

下面我们来看下如何个人如何部署deepseek-r1模型。 我是用的仙宫云的服务器通过ollama部署的deepseek. 首先我们去ollama官方网站https://ollama.com/ 下载ollama  我这里是ubuntu服务器,执行命令 curl -fsSL https://ollama.com/install.sh | sh 安装之后ollama之后, 由于我需要外网访问,改下环境配置 export OLLAMA_HOST=0.0.0.0:11434; export OLLAMA_ORIGINS= * 再执行ollama serve启动

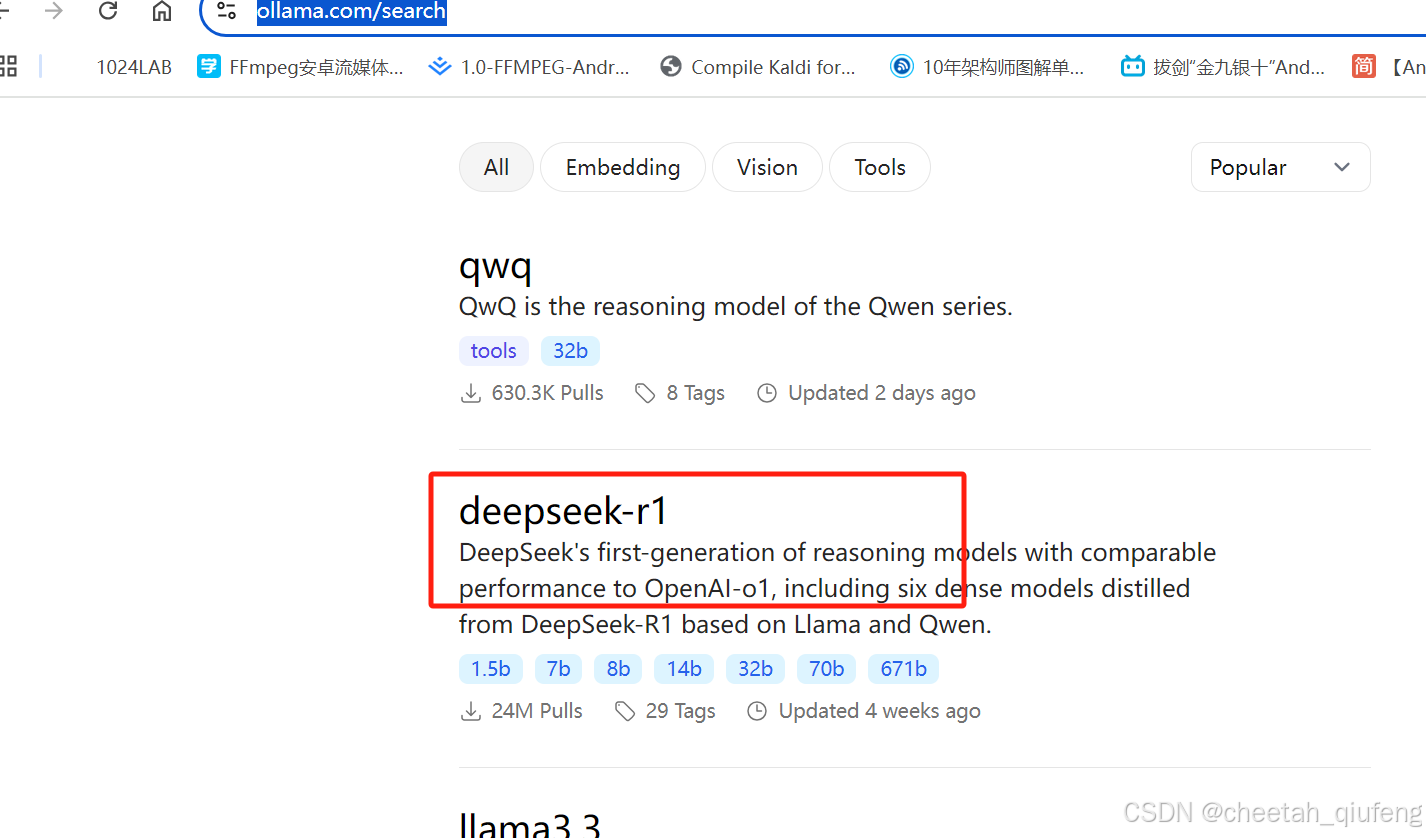

我这里是ubuntu服务器,执行命令 curl -fsSL https://ollama.com/install.sh | sh 安装之后ollama之后, 由于我需要外网访问,改下环境配置 export OLLAMA_HOST=0.0.0.0:11434; export OLLAMA_ORIGINS= * 再执行ollama serve启动  去ollama上找下deepseek 模型 https://ollama.com/search

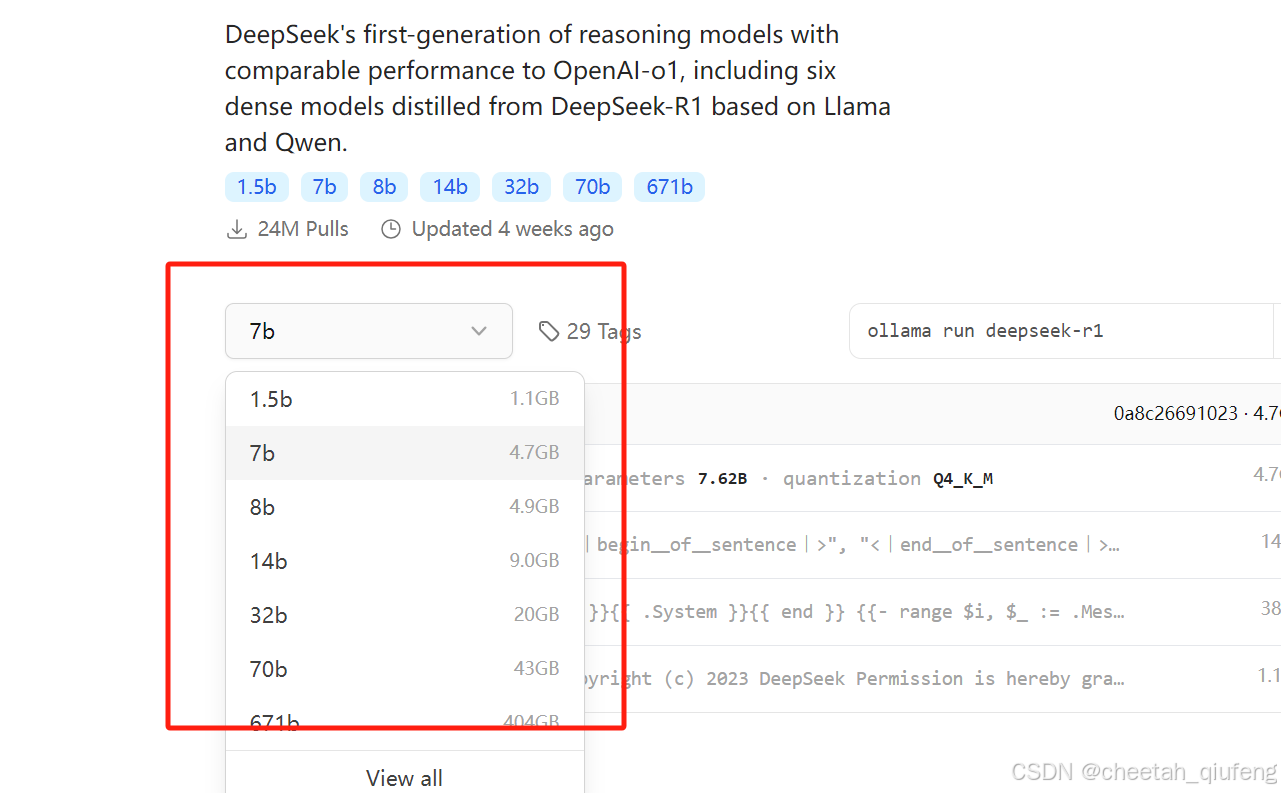

去ollama上找下deepseek 模型 https://ollama.com/search  deepseek有很多参数的模型可以选择,根据自己的机器选择

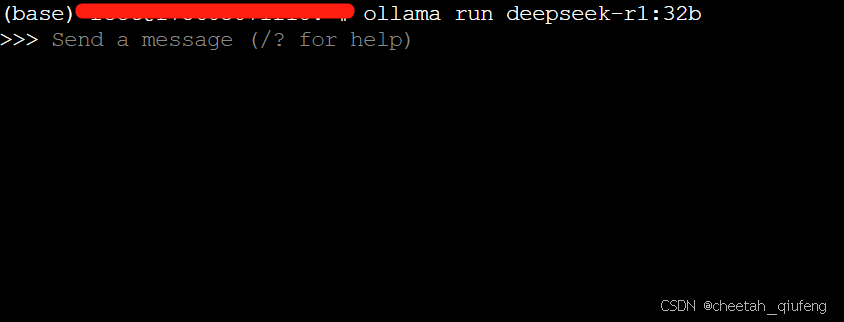

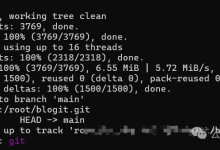

deepseek有很多参数的模型可以选择,根据自己的机器选择  我这里是一台4090D,选择了32b的模型 执行ollama run deepseek-r1:32b就可以下载模型,下载完成出现下图这个命令行发送信息的提示就算成功。

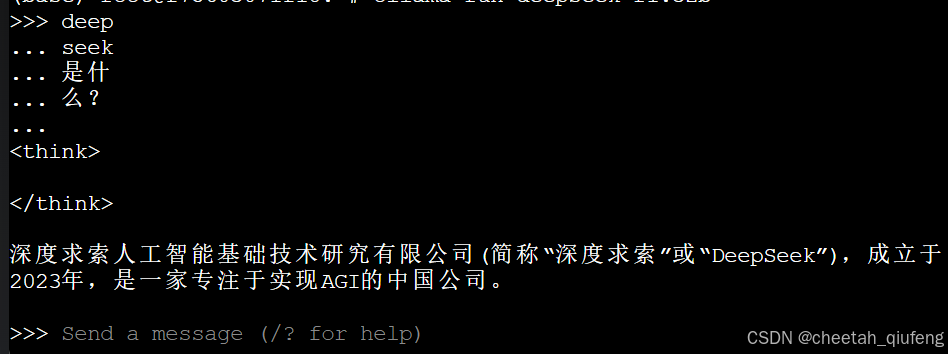

我这里是一台4090D,选择了32b的模型 执行ollama run deepseek-r1:32b就可以下载模型,下载完成出现下图这个命令行发送信息的提示就算成功。  测试下效果,好了部署是没问题了,在命令行太不方便了,这里我们用chatbox来配置带有界面的聊天。

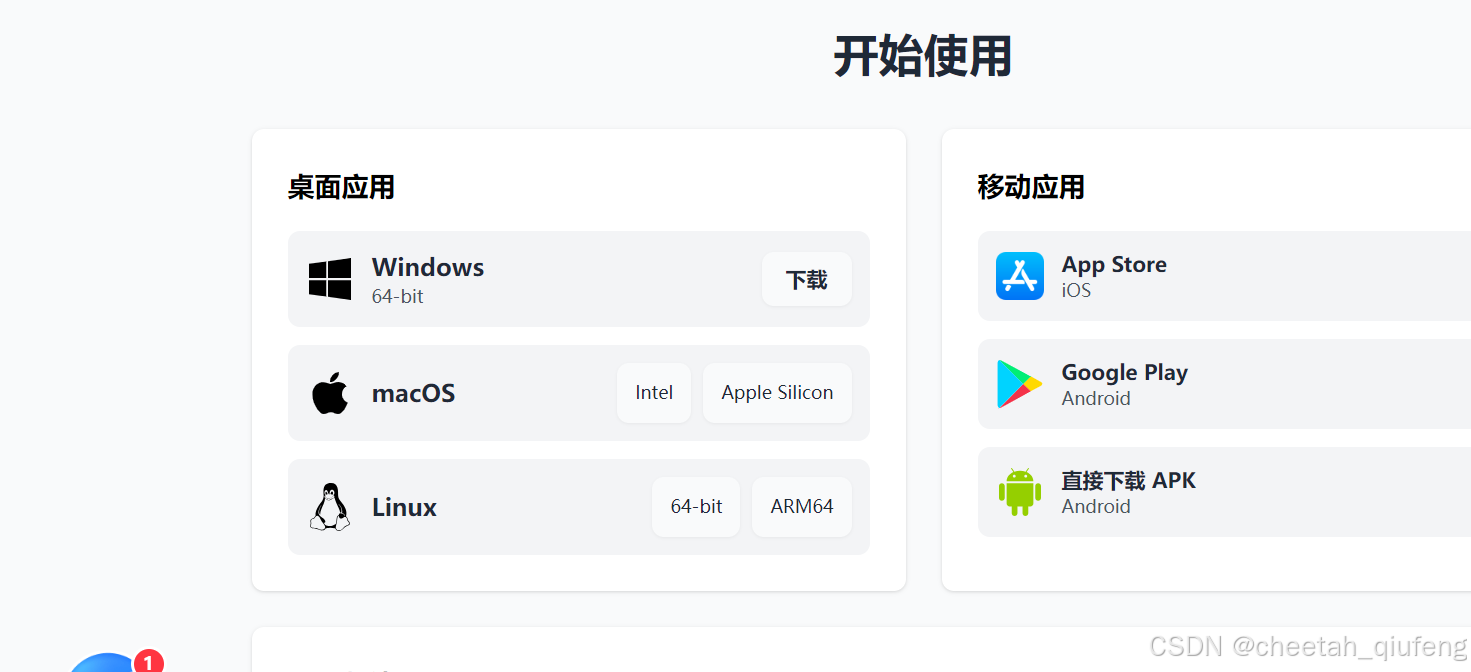

测试下效果,好了部署是没问题了,在命令行太不方便了,这里我们用chatbox来配置带有界面的聊天。  下载个chatbox https://chatboxai.app/zh#download

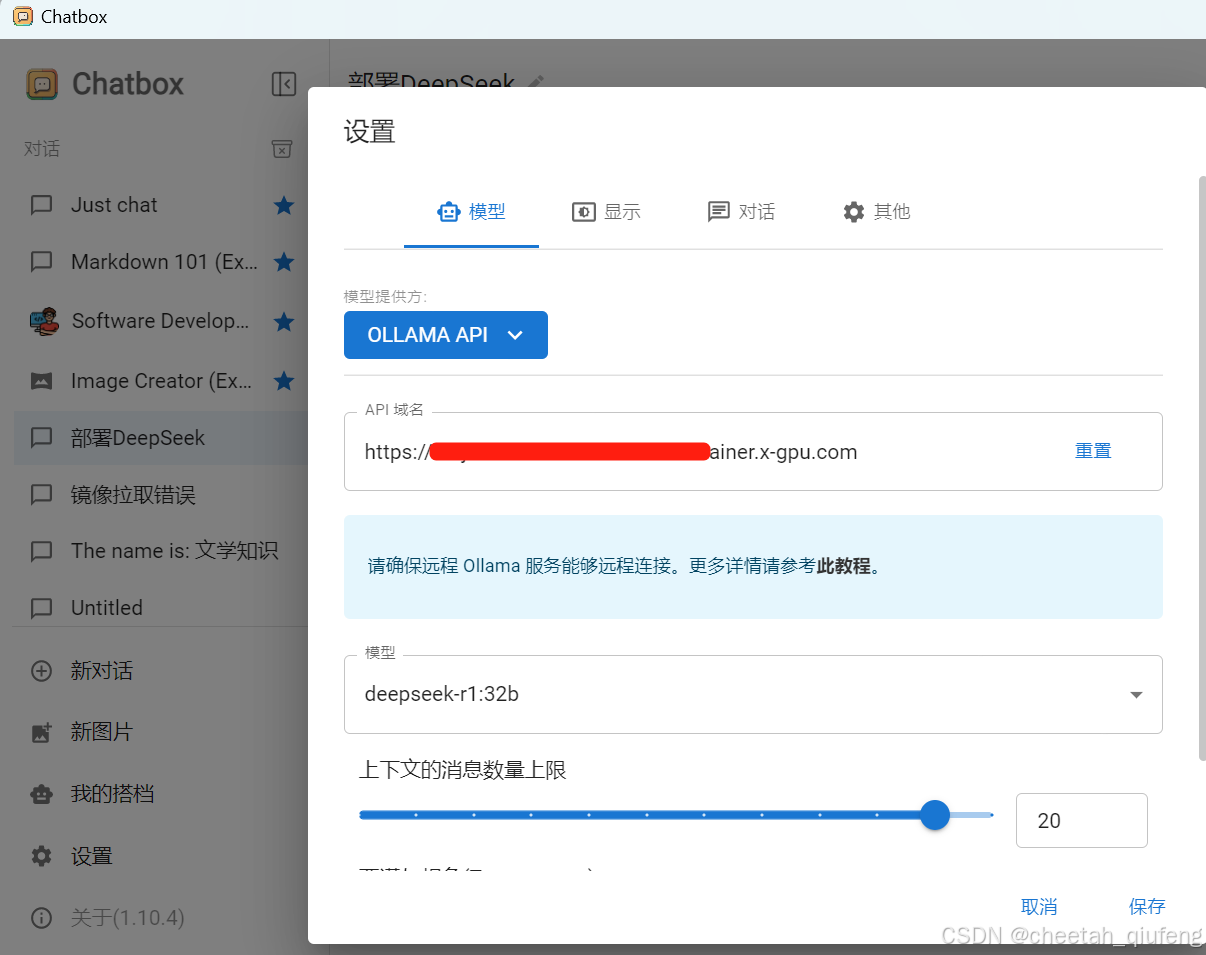

下载个chatbox https://chatboxai.app/zh#download  这里我选择window客户端 配置在仙宫云服务器的域名地址

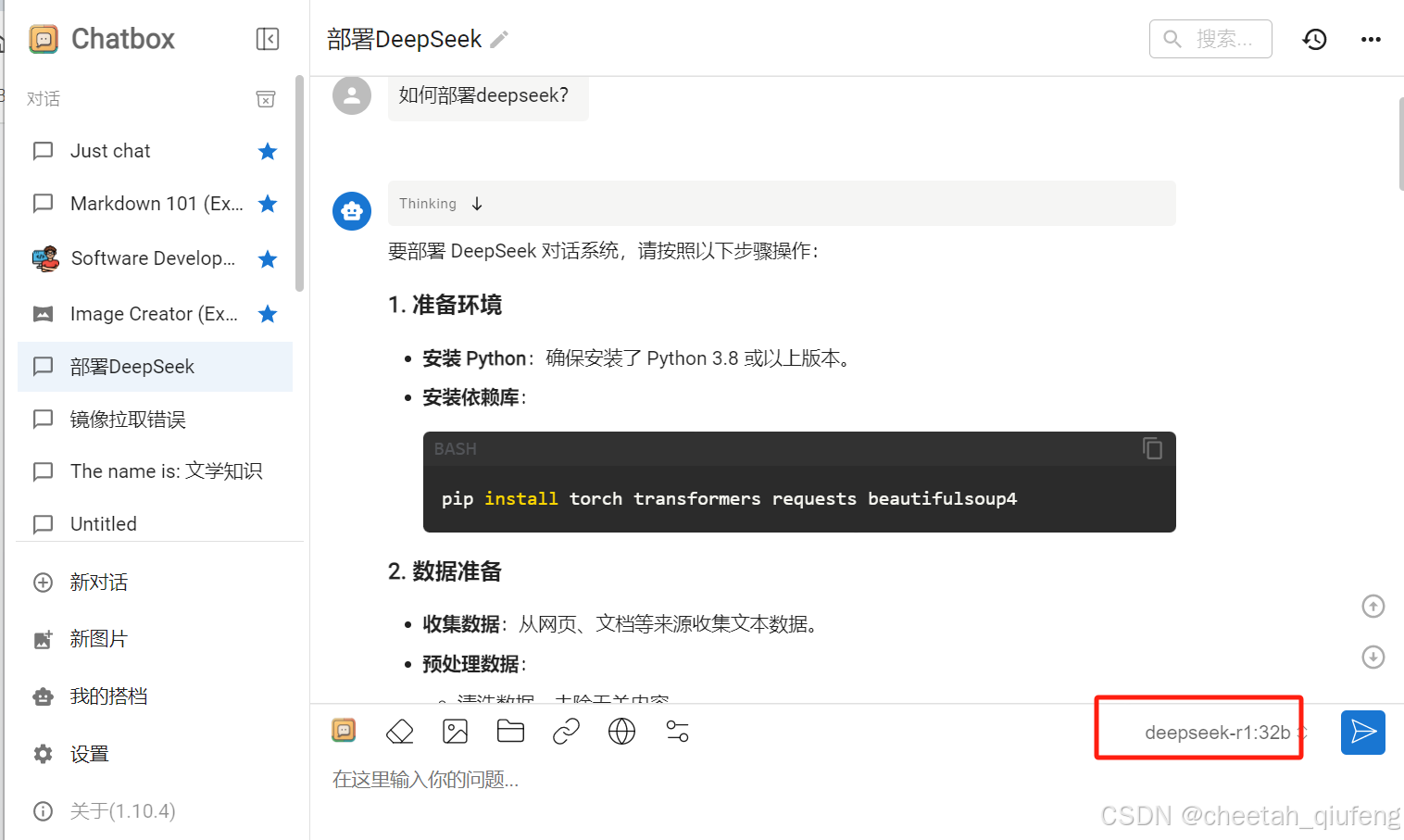

这里我选择window客户端 配置在仙宫云服务器的域名地址  配置好了之后会自动选择deepseek-r1:32b的模型 测试下效果,问deepseek如何部署,很快就出结果了,聊天框哪里会显示deepseek-r1:32b模型

配置好了之后会自动选择deepseek-r1:32b的模型 测试下效果,问deepseek如何部署,很快就出结果了,聊天框哪里会显示deepseek-r1:32b模型  好了这就是ollama部署的整个deepseek的流程,是不是很简单。

好了这就是ollama部署的整个deepseek的流程,是不是很简单。

.

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册