将YOLO目标检测代码移植到Jetson Nano或树莓派上,主要分为以下几个步骤:

通过这些步骤,你可以在Jetson Nano或树莓派上成功部署YOLO目标检测系统,实现实时的目标识别和分析。

边缘计算可以让这些小型、低功耗的设备具备强大的目标检测能力,适用于各种边缘计算场景。以下是一个详细的步骤指南,帮助你完成移植过程。

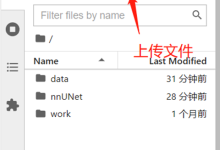

一、准备工作

软件代码准备 首先以行人监测为例子说明

为了实现实时获取视频流并使用 YOLO 目标检测算法监测行人,我们可以使用 Python 和 OpenCV 库。以下是一个完整的示例代码,展示了如何从摄像头获取实时视频流,并使用 YOLOv5 模型检测行人。

环境准备

安装依赖库

bash

pip install opencv-python numpy torch torchvision

克隆 YOLOv5 仓库并安装依赖

bash

git clone https://github.com/ultralytics/yolov5.git

cd yolov5

pip install -r requirements.txt

下载预训练权重

bash

wget https://github.com/ultralytics/yolov5/releases/download/v1.0/yolov5s.pt

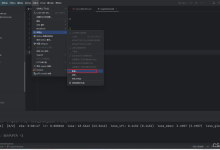

代码实现

python

import cv2

import torch

from yolov5.models.experimental import attempt_load

from yolov5.utils.datasets import letterbox

from yolov5.utils.general import non_max_suppression, scale_coords

from yolov5.utils.torch_utils import select_device

# 加载 YOLOv5 模型

weights = \’yolov5s.pt\’ # 模型权重文件

device = select_device(\’\’) # 选择设备,\’\’ 表示自动选择

model = attempt_load(weights, map_location=device) # 加载模型

stride = int(model.stride.max()) # 模型的步长

# 设置摄像头

cap = cv2.VideoCapture(0) # 0 表示默认摄像头

# 循环读取视频帧

while True:

ret, frame = cap.read()

if not ret:

break

# 图像预处理

img = letterbox(frame, new_shape=640, stride=stride)[0]

img = img.transpose((2, 0, 1))[::-1] # HWC to CHW, BGR to RGB

img = np.ascontiguousarray(img)

img = torch.from_numpy(img).to(device)

img = img.float() # uint8 to fp16/32

img /= 255.0 # 图像归一化

if img.ndimension() == 3:

img = img.unsqueeze(0)

# 模型推理

pred = model(img, augment=False, visualize=False)[0]

# 应用 NMS

pred = non_max_suppression(pred, 0.25, 0.45, classes=None, agnostic=False)

# 处理检测结果

for i, det in enumerate(pred): # 遍历每个检测结果

s = \’\’

s += \’%gx%g \’ % img.shape[2:] # 打印图像尺寸

gn = torch.tensor(frame.shape)[[1, 0, 1, 0]] # 归一化增益

if len(det):

# 将坐标从 [0, 1] 转换为像素坐标

det[:, :4] = scale_coords(img.shape[2:], det[:, :4], frame.shape).round()

# 遍历每个检测到的目标

for *xyxy, conf, cls in reversed(det):

if int(cls) == 0: # 0 表示行人

x1, y1, x2, y2 = map(int, xyxy) # 坐标转换为整数

label = f\’Pedestrian {conf:.2f}\’

cv2.rectangle(frame, (x1, y1), (x2, y2), (0, 255, 0), 2)

cv2.putText(frame, label, (x1, y1 – 10), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 255, 0), 2)

# 显示结果

cv2.imshow(\’Pedestrian Detection\’, frame)

# 按 \’q\’ 键退出

if cv2.waitKey(1) & 0xFF == ord(\’q\’):

break

# 释放摄像头资源

cap.release()

cv2.destroyAllWindows()

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册