最近DeepSeek大火,很多人都想用DeepSeek,但是无奈经常提示服务器繁忙,那就试试将DeepSeek部署到自己电脑上吧!不仅能用DeepSeek,还能联网搜索、生成图片!并且,Win和Mac都可以使用!

PART ONE

部署DeepSeek到本地

推荐大家使用Ollama进行部署,非常简单,有手就行

🏗️ 安装Ollama

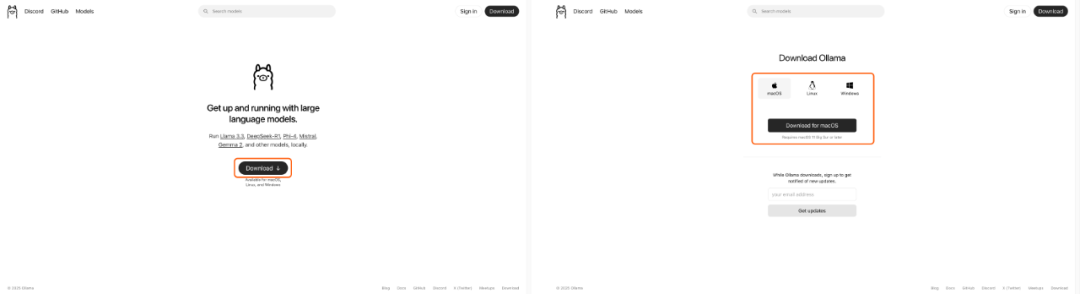

去Ollama官网(https://ollama.com/)根据自己的系统选择下载对应的安装包安装即可

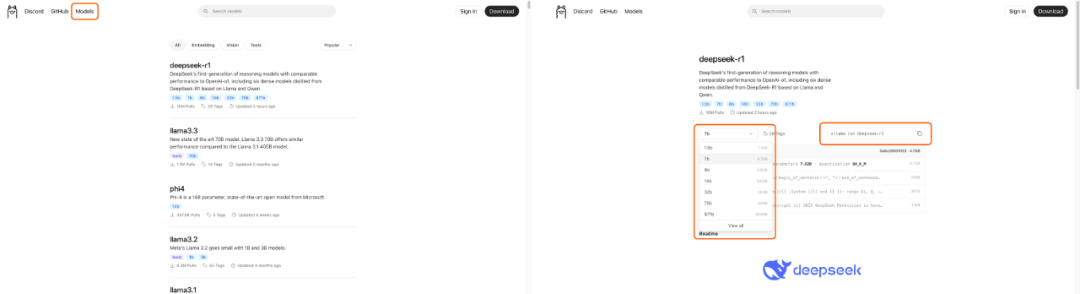

🧱 下载DeepSeek模型

在Ollama官网中点Model选项,DeepSeek在第一个,点击进入模型详情页,根据自己的需求选择对应的模型大小,例如7b、32b。选择好对应的模型尺寸后点击右侧的按钮复制命令即可(如果不知道该如何选,请看文章底部的QA部分)

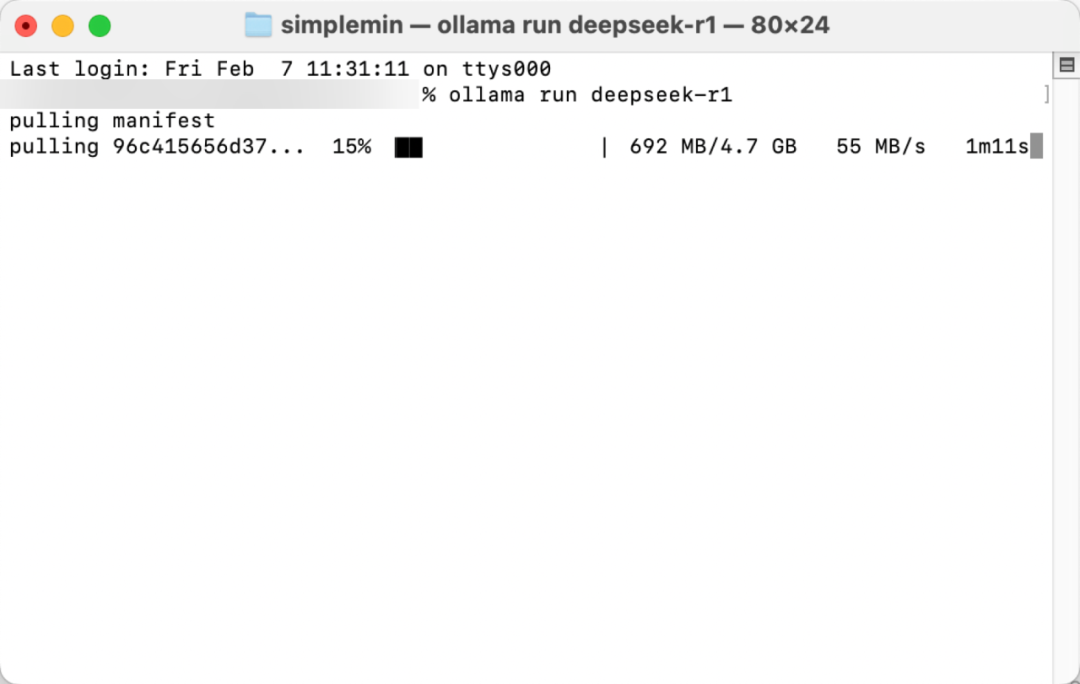

复制好命令后,Windows用户打开Powershell、Mac用户打开终端,将刚刚复制的代码粘贴进去,按回车即可自动下载模型,等待模型下载完成即可使用(Windows系统会默认下载到C盘,如果想要修改请看文章底部的QA部分)

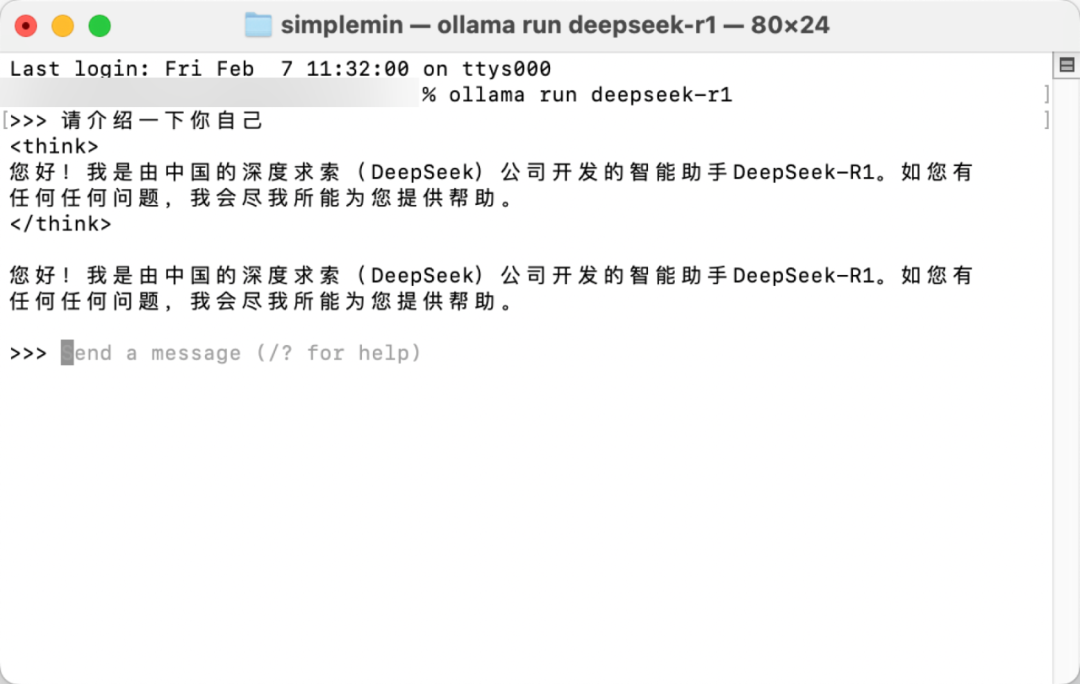

💬 跟DeepSeek对话

模型下载完成之后,即可正常进行对话,关闭Powershell或者终端则退出对话,下次如果还需要进行对话的话,再次打开Powershell或者终端,输入命令 ollama run 模型名称 即可启动模型开始对话

# 运行模型``ollama run 模型名称`` ``# 例如:``ollama run deepseek-r1:32b

至此,DeepSeek部署到本地已经完成可以使用啦。不过,这样用起来是不是还觉得不够方便?请看后面

PART TWO

本地部署LLM应用开发平台

当我们通过Ollama将LLM部署到本地后,总会觉得有点麻烦,比如只能在 Powershell/终端 中通过命令行的形式跟AI进行对话,比如无法使用AI Agent、联网搜索。本地部署后使用起来总觉得比在线工具差了点什么,而LLM应用开发平台就是弥补这些缺点的存在。让AI在你的电脑里 满血复活

🏗️ 安装Docker

Docker类似于虚拟机,可以将许多复杂的项目和软件一键运行,非常方便,推荐新手和小白使用。前往Docker官网(https://www.docker.com/)根据自己的系统下载安装Docker即可

🏗️ 安装OpenWebUI

OpenWebUI轻量、简单,对新手非常友好,因此推荐大家使用。Windows用户打开Powershell、Mac用户打开终端,输入以下代码按回车就可以一键部署OpenWebUI

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main

输入代码后,耐心等待下载镜像,镜像下载完成后会自动安装,安装完成后打开浏览器访问 http://localhost:3000 就可以访问OpenWebUI了

PART THREE

配置联网搜索、图像生成

让AI联网搜索、图像生成

🔗 将Ollama与OpenWebUI关联

访问 http://localhost:3000/ 进入OpenWebUI页面,点击左下角头像,在浮层中选择管理员面板

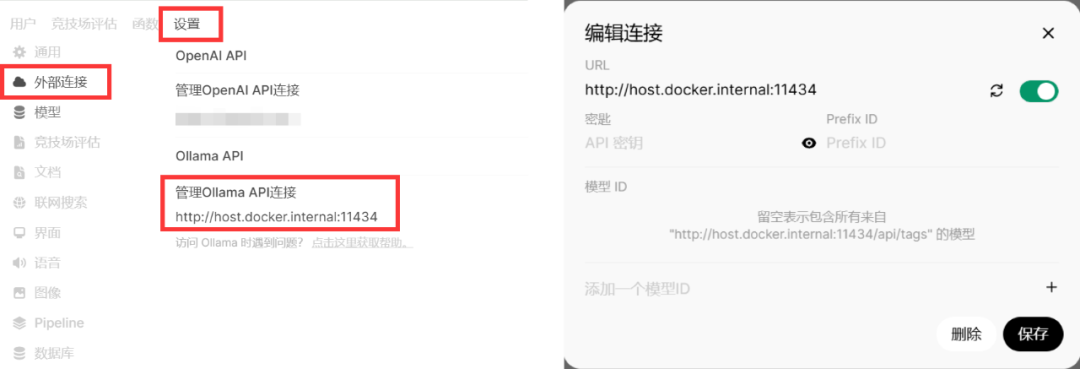

在管理员面板中点击右上角的设置选项,切换到系统设置,然后选择外部连接选项,将Ollama API连接点击启用,URL中输入 http://host.docker.internal:11434 ,其余留空即可,记得一定要点保存!

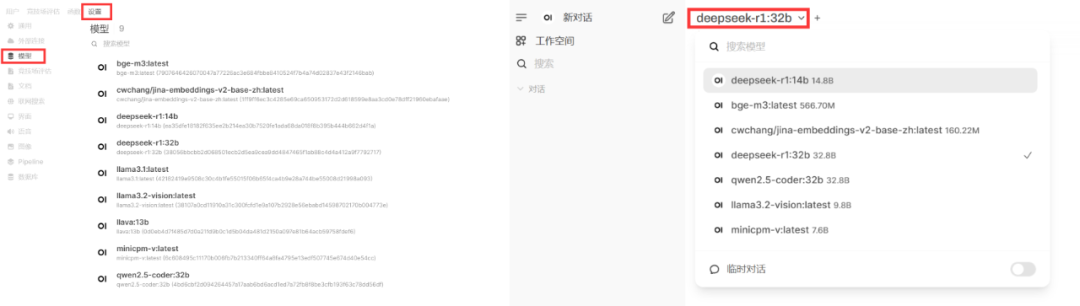

Ollama API填写完成后,就可以在模型中看到已经部署到本地的模型了,此时点击新对话,在左上角就可以选择模型并进行切换了,此时就可以在WebUI中使用DeepSeek了,是不是比之前方便多了

小知识:在同一个局域网下,任意设备访问 http://localhost:3000 都可以使用DeepSeek了

🛜 配置联网搜索

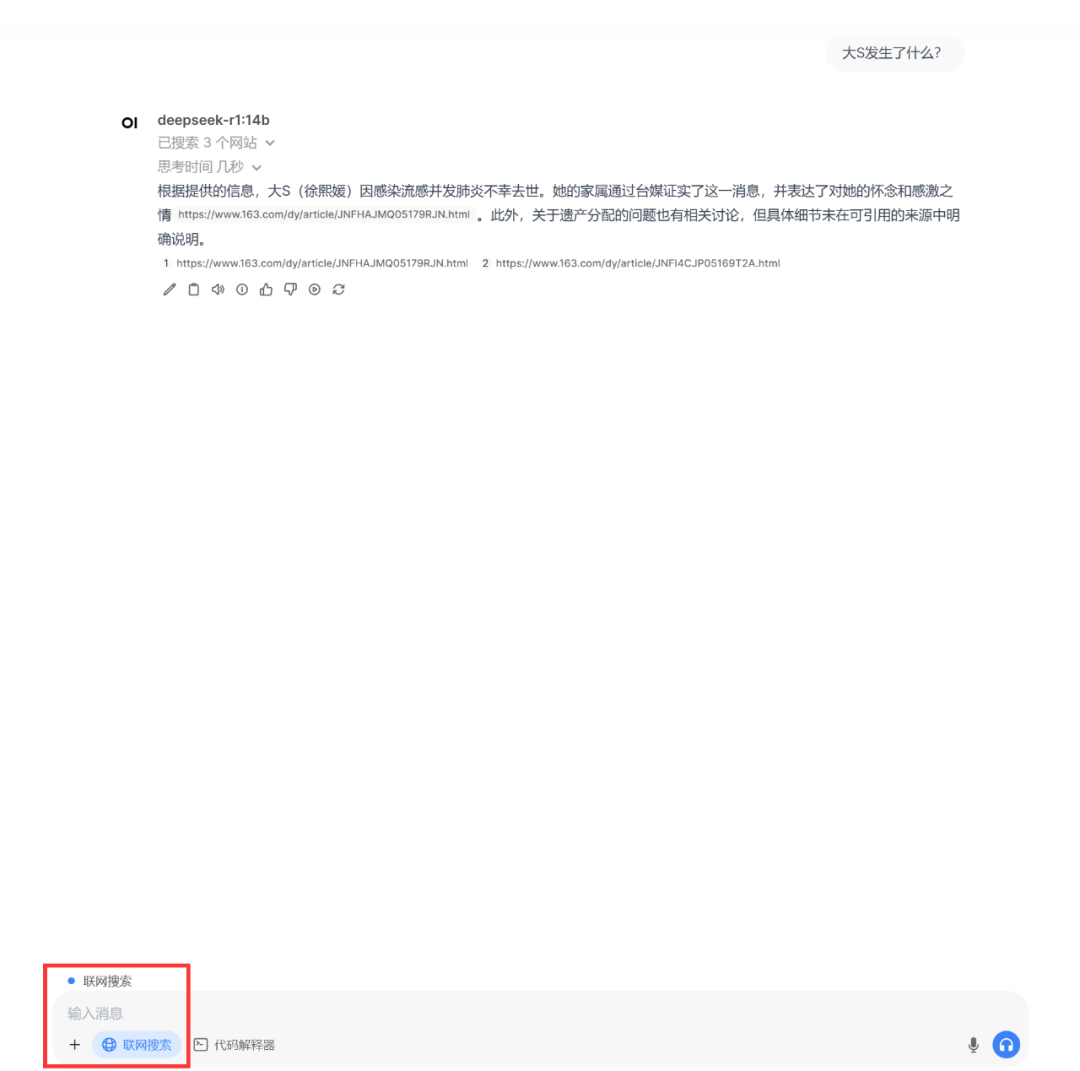

进入管理员面板,点击右上角的设置,找到 联网搜索 选项,在右侧点击开启,并将搜索引擎改成duckduckgo保存(为什么是duckduckgo?因为免费,且不需要注册各种乱七八糟的东西)。设置完成后在对话中就出现了联网搜索的选项,勾选即可在使用AI的时候进行联网搜索

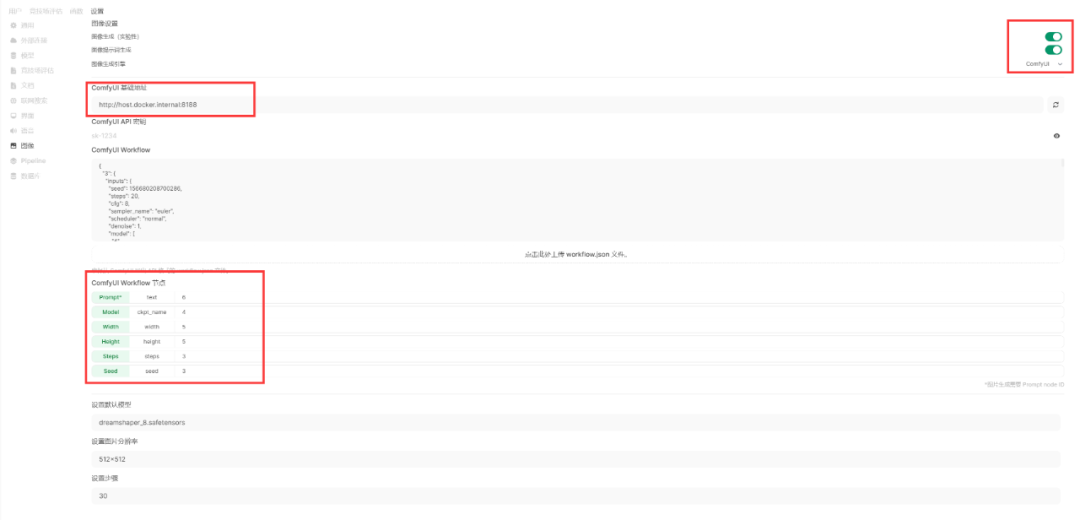

🎨 配置图像生成

进入管理员面板,点击右上角的设置,找到 图像 选项,在右侧点击开启,并根据实际情况选择WebUI还是ComfyUI,这里以ComfyUI为例。在ComfyUI地址这一栏中填写 http://host.docker.internal:8188 (需要提前运行ComfyUI),然后在下方Workflow中上传一个API Json文件,上传后需要检查下方Prompts、Model这些参数后面ID是否跟Workflow里保持一致,如果不一致需要手动修改。最后在最下方设置好默认模型、分辨率、步数即可,记得点保存!

配置完成后在对话中就出现了图像生成的选项,点击就可以在对话中生成图片了(别忘了运行ComfyUI)

QA PART

**大家常见的疑问也都整理在这了 **

Q:7b、32b这么多大小我该如何选择?

A:7b、32b中的b是billion的简写,指的是数据量大小。可以简单的理解为,模型数据量越大(b的值越大),质量越高。但是相对的,模型体积也就越大,所需要硬件要求也就越高,这就导致运行速度会变慢。根据自己硬件条件、能接受的响应速度、响应质量自己选择即可

Q:电脑硬件有什么要求?

A:简单可以使用公式 显存+内存>模型大小 来作为选择的参考。这里的模型大小指的是模型体积,也就是多少G多少G,不是参数量(b)。例如显存12G,内存16G,那么模型大小小于28G的都可以使用(就比如Ollama中的DeepSeek R1 32b的模型大小是20G,可以使用,但是70b模型大小是43G就不能使用)。但是需要注意,当模型大小超过显存时,会调用CPU进行计算,速度会大大降低。因此,模型大小越大于显存大小,运行速度越慢

Q:Windows用户如何将Ollama模型放在其他盘,非C盘?

A:右键 我的电脑 选择 属性,在属性页面中点击 高级 ,然后找到 环境变量 入口,在 用户变量中 新建一个名为 OLLAMA_MODELS 的变量,值就是希望保存模型的目录,例如 D:\\OllamaModels ,点击保存即可

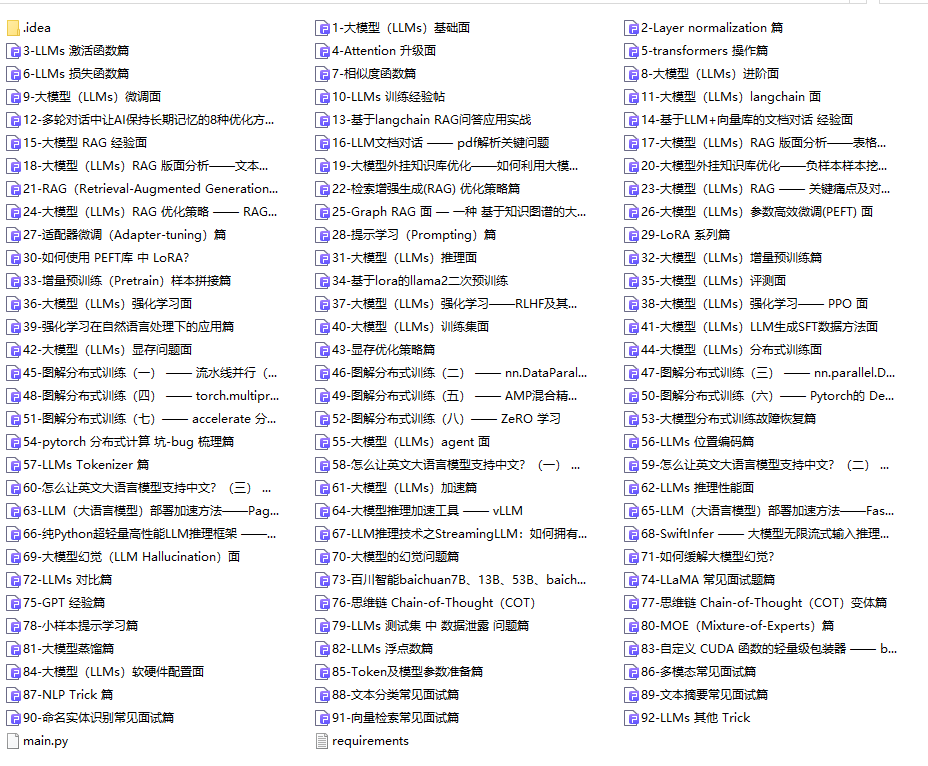

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

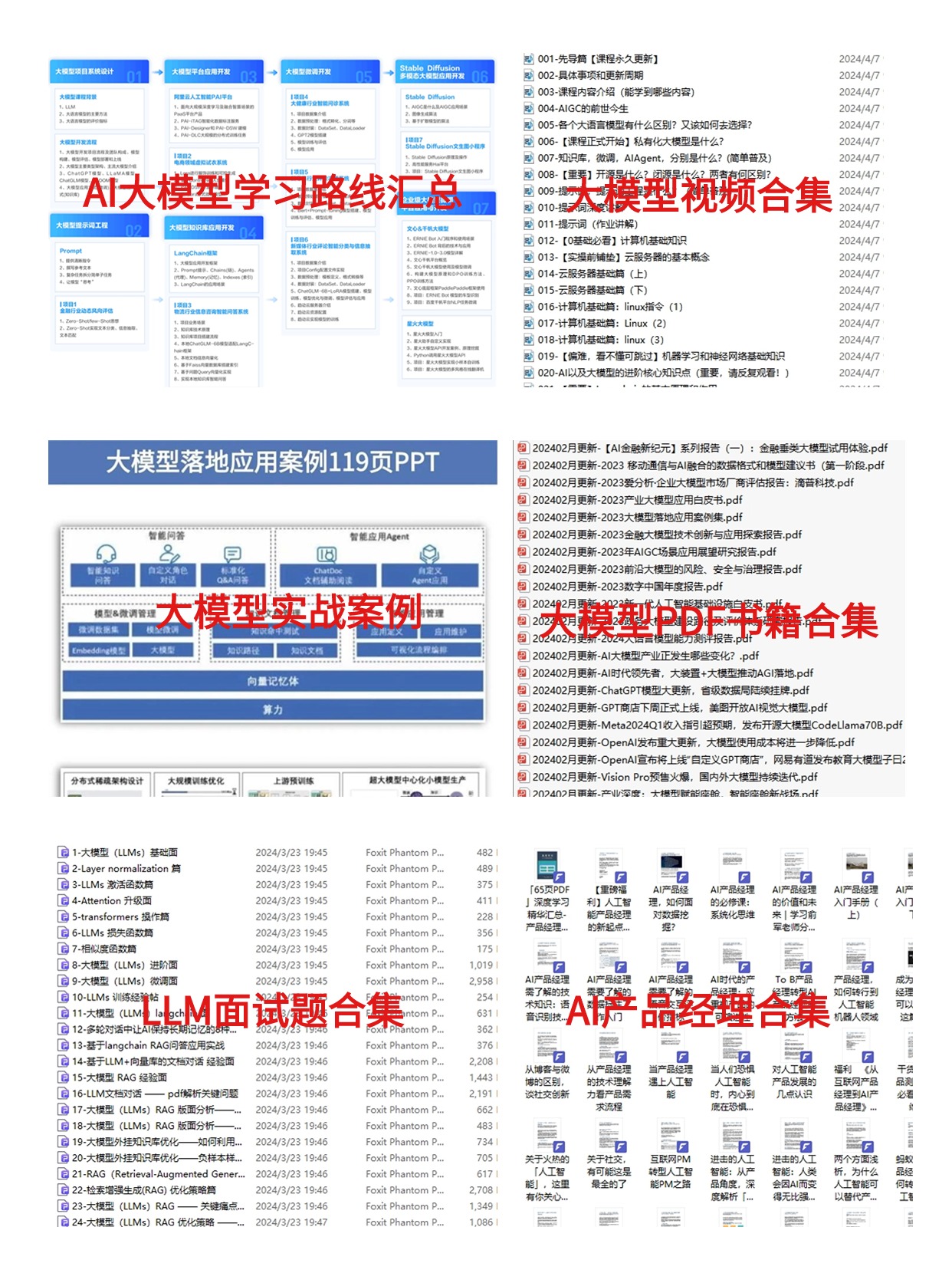

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

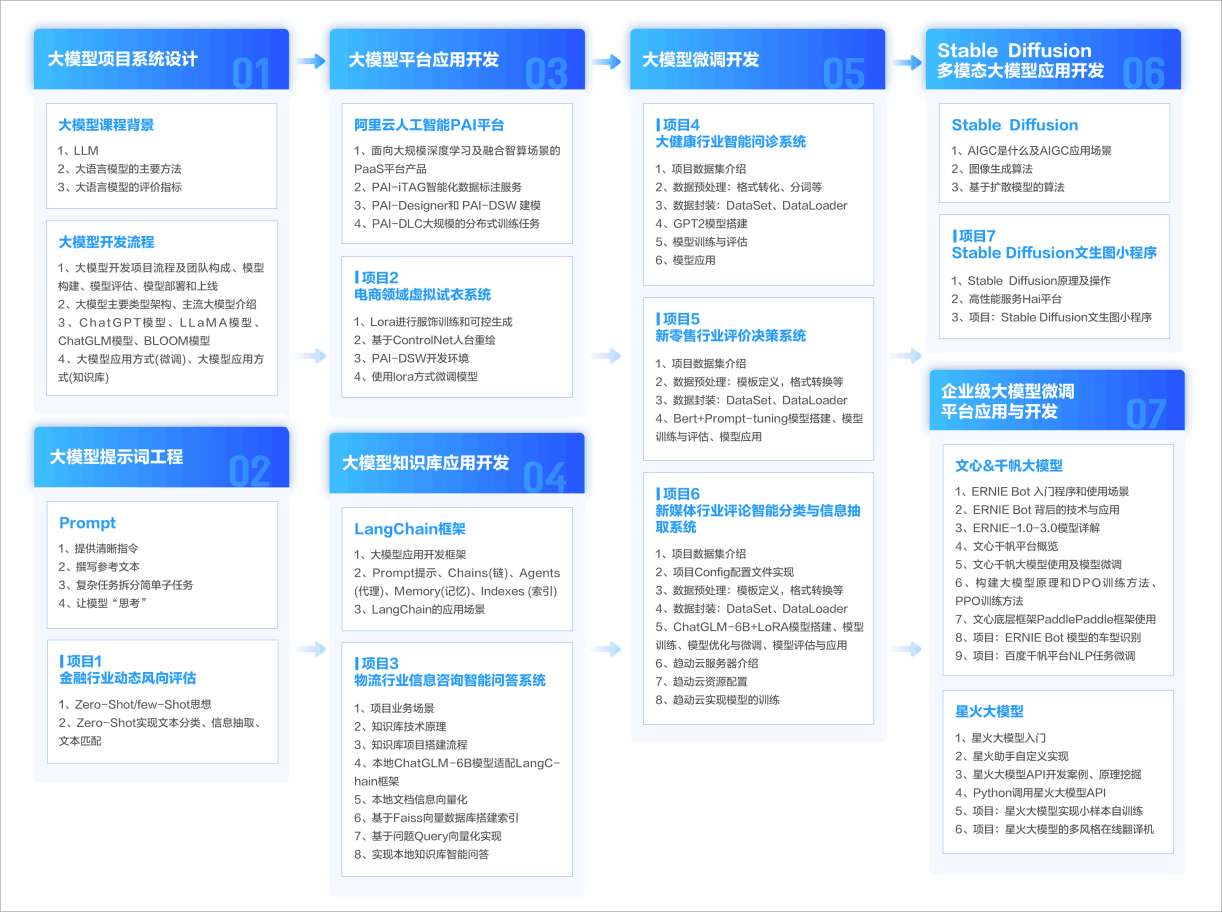

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

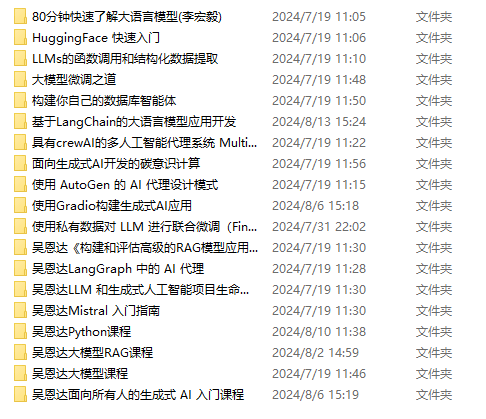

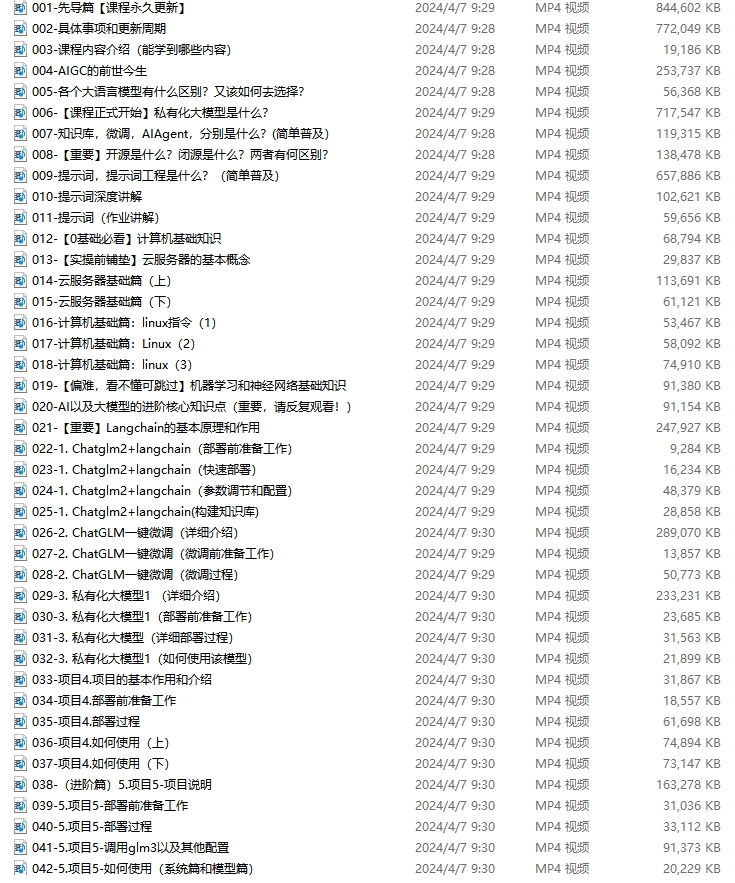

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

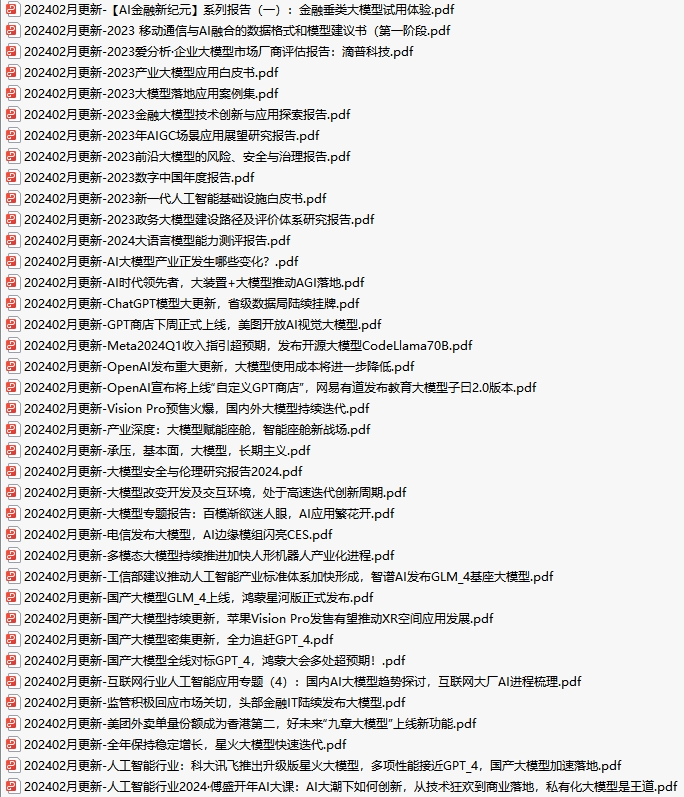

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈 • 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图 2.100套AI大模型商业化落地方案 3.100集大模型视频教程 4.200本大模型PDF书籍 5.LLM面试题合集 6.AI产品经理资源合集

👉获取方式: 😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册