查看显卡信息

可以看到显存占用、显存大小等信息 nvidia -smi

一、安装ollama

安装deepseek-R1前,需要先安装ollama(本文通过ollama形式安装),如已安装,跳过该步骤。

curl -fsSL https://ollama.com/install.sh | sh

验证安装结果

ollama –version

二、安装deepseek-R1

ollama安装成功后,下载dsr1大模型,这里用7b版本,保证稳定性。

ollama run deepseek-r1:7b

出现可以对话的命令行,即代表安装成功。

三、安装Dify

Dify可以实现文档上传并提取文档内容,通过工作流把提取的信息丢给DeepSeek,从而达到DeepSeek上传文档对话功能。

Dify官方推荐使用docker安装:

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

下面选配,默认配置已满足基础需求

# 按需修改数据库密码、API密钥、端口等参数

nano .env # 或使用vim/其他编辑器

docker compose up -d # Docker Compose V2

# 或使用旧版命令:docker-compose up -d

启动成功后,看下容器docker-nginx-1对外暴露的端口,默认是80(如果修改过.env配置文件中的EXPOSE_NGINX_PORT,那么以修改后的端口号为准). 直接http://ip:port即可访问

四、Dify与ds集成

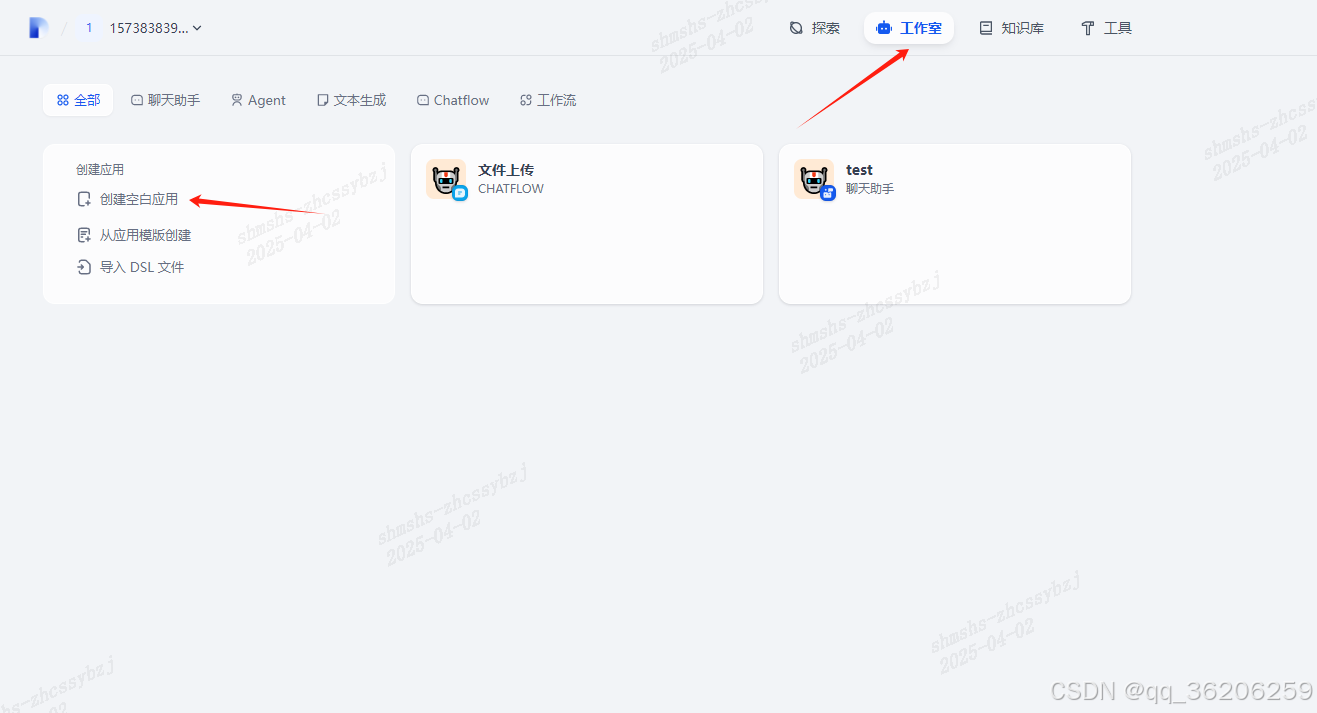

1. 登录后,打开工作室——》创建空白应用

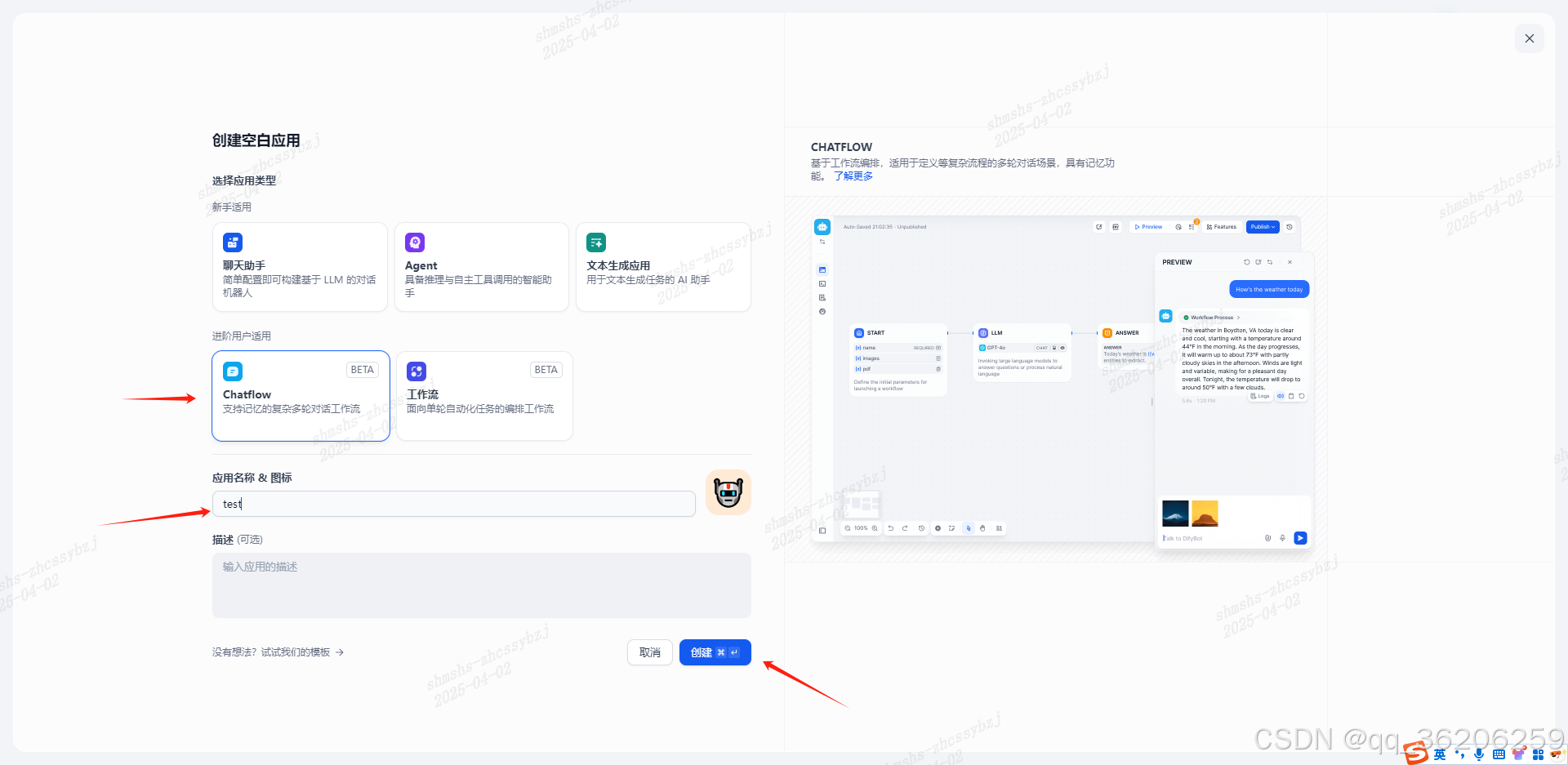

2. 创建一个新的应用,选择Chatflow——》输入应用名称——》创建

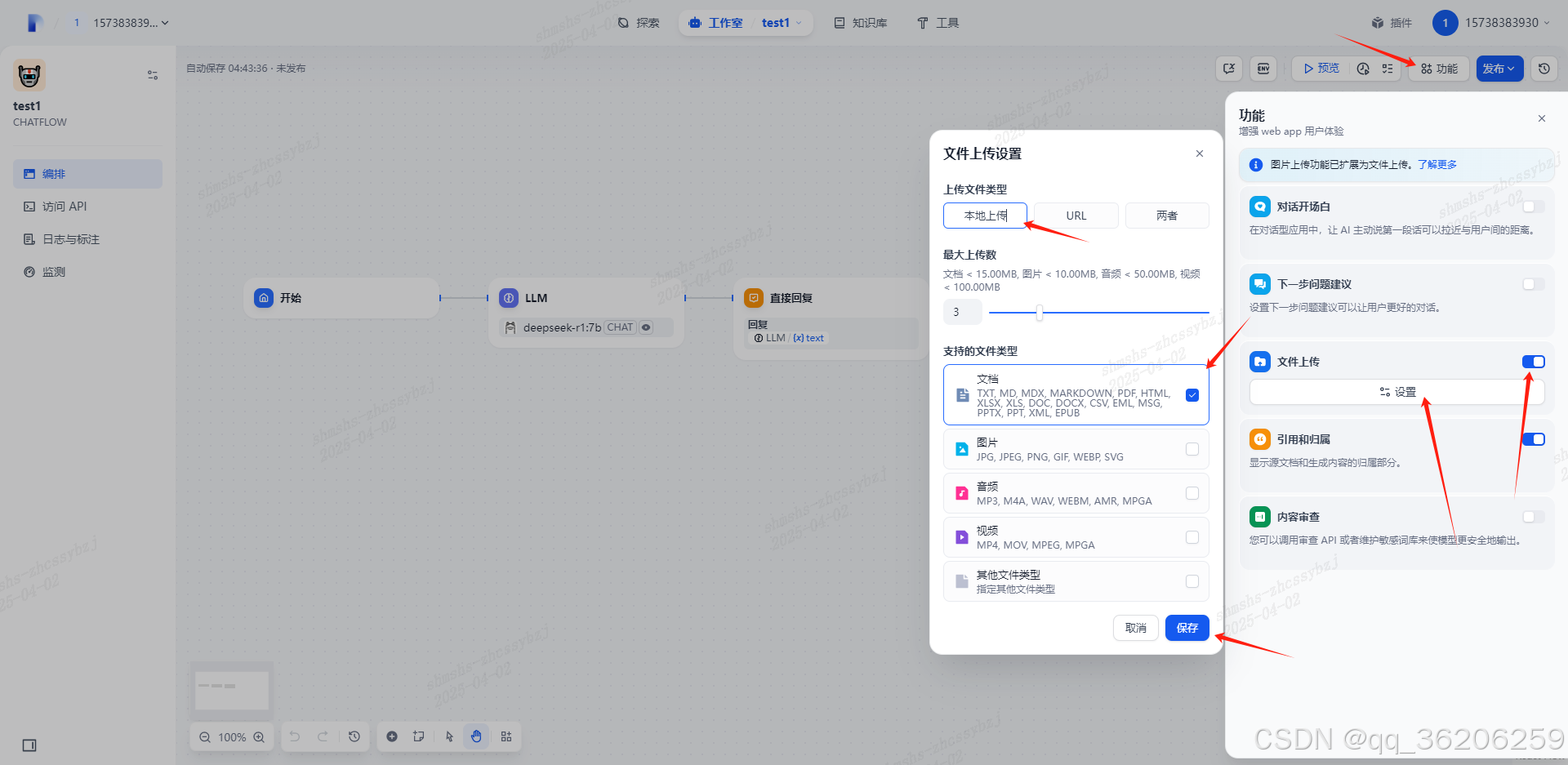

3. 选择功能——》打开文件上传功能——》点击设置按钮,自定义文件上传属性设置——》保存

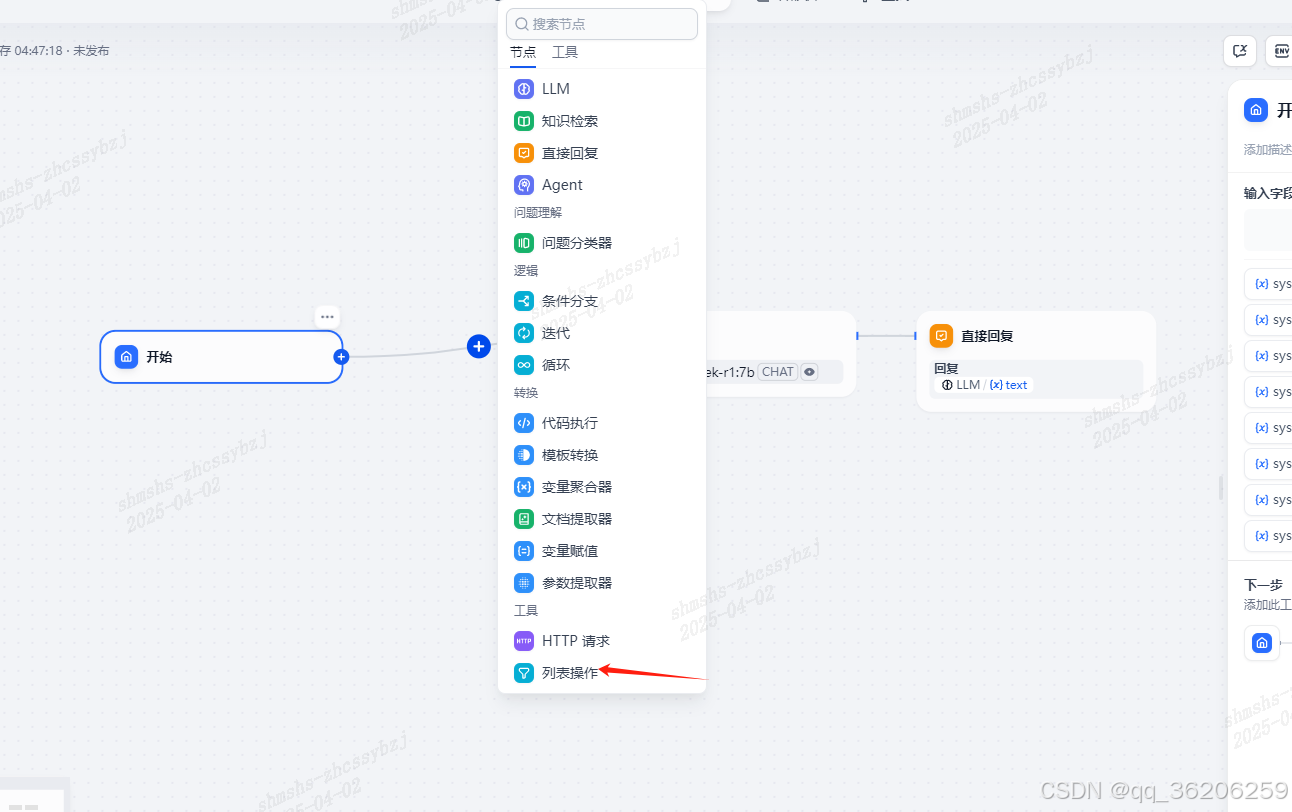

4. 在LLM节点的前面加上一个列表操作的节点,用来识别对话的时候是否上传了文件

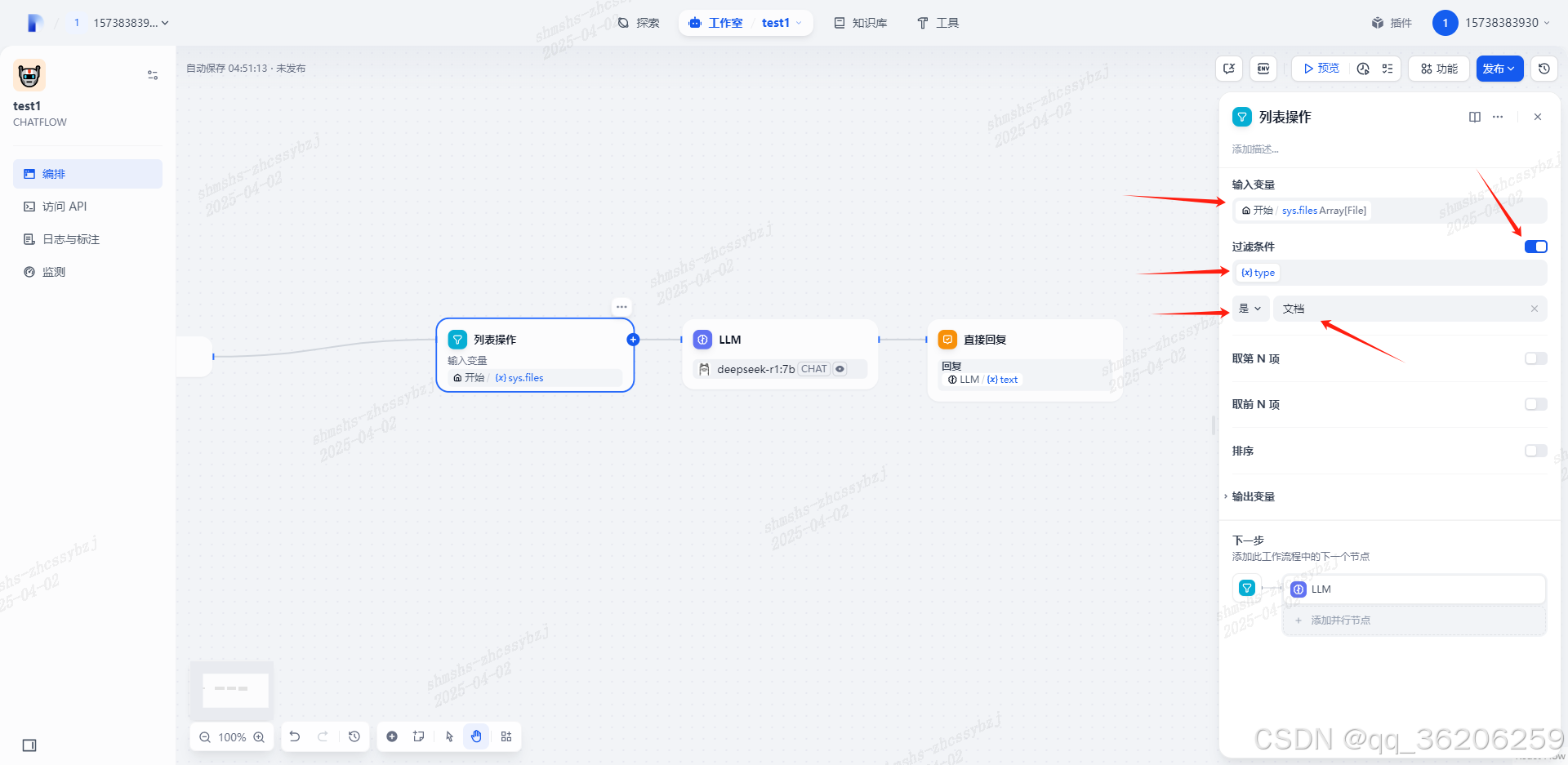

5. 配置列表操作节点——按下图设置 输入变量、开启过滤条件、属性为文档

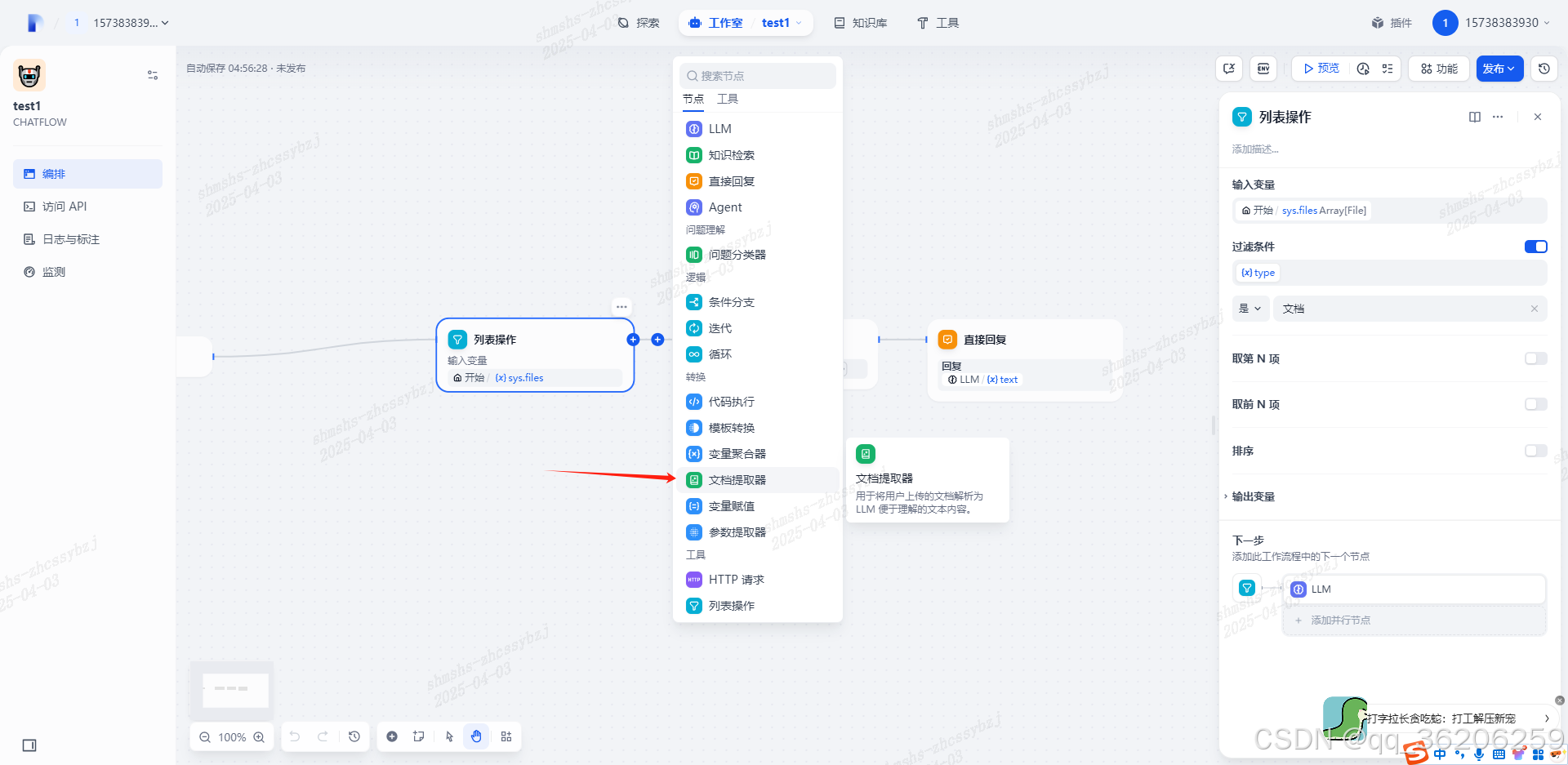

6. 列表操作节点后面添加一个文档提取器,把上传的文档数据识别出来

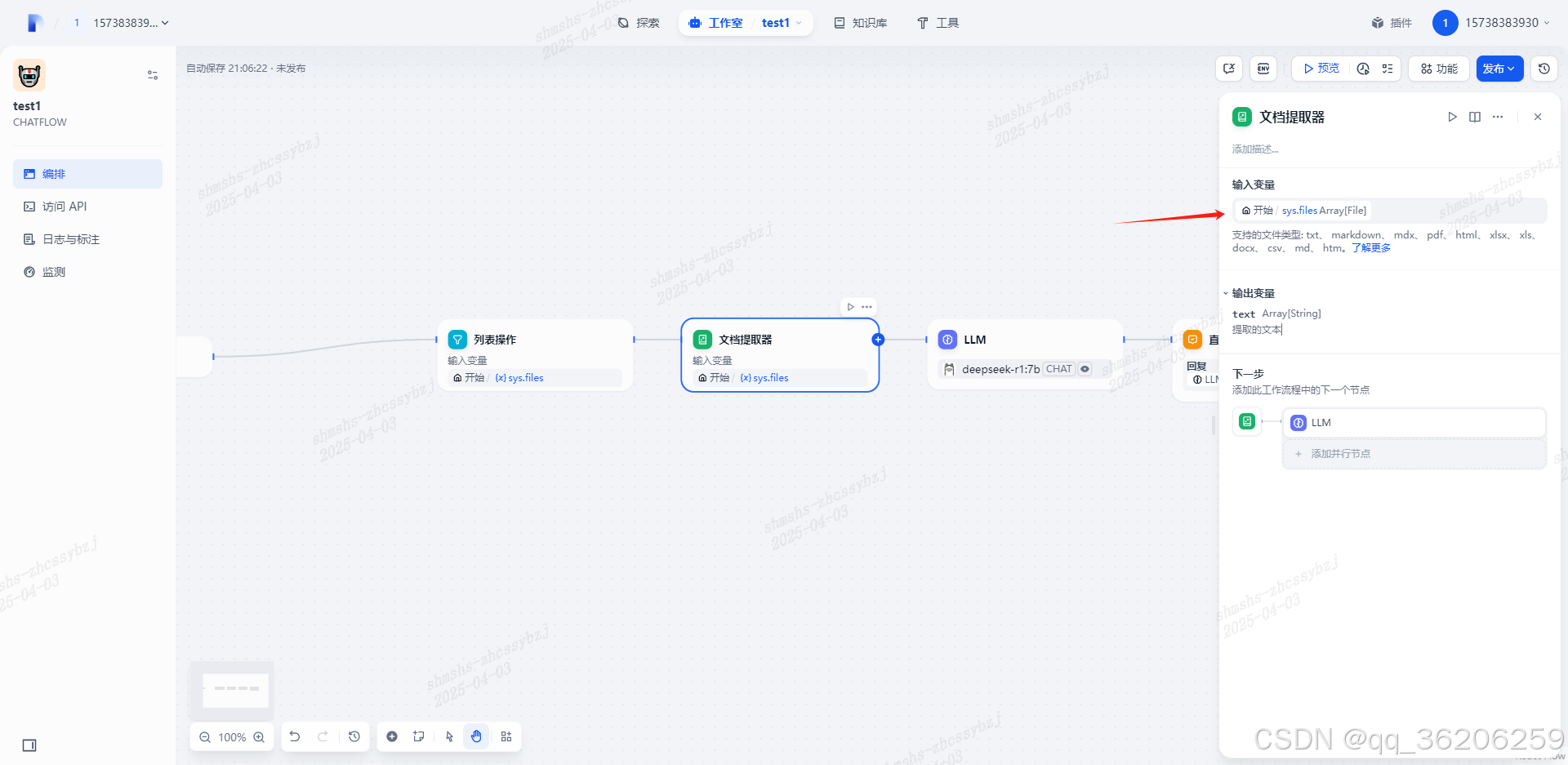

7. 配置文档提取器

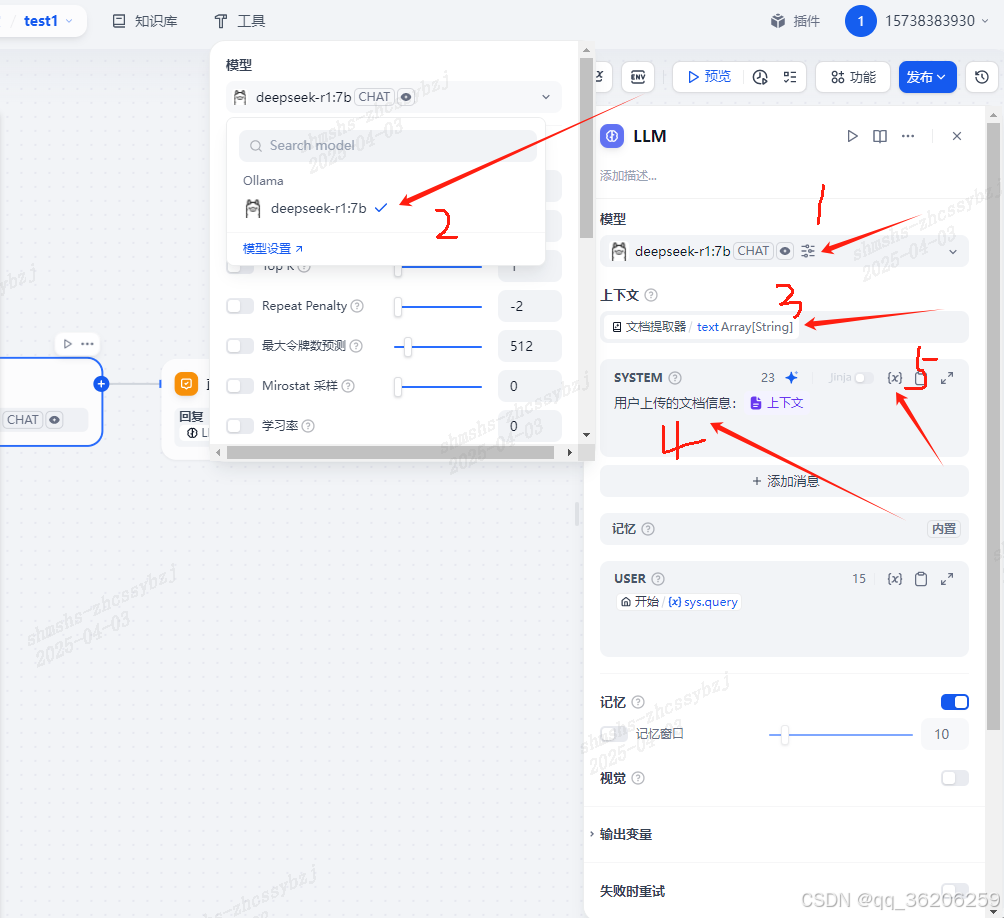

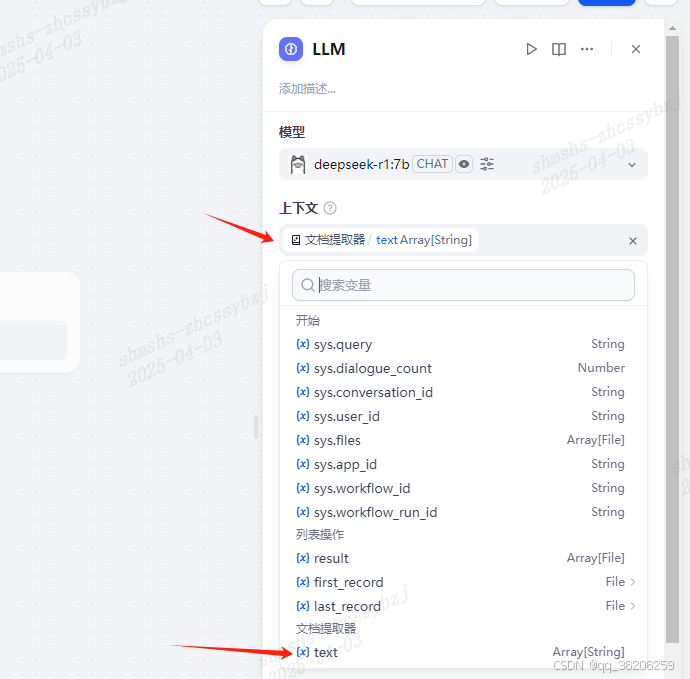

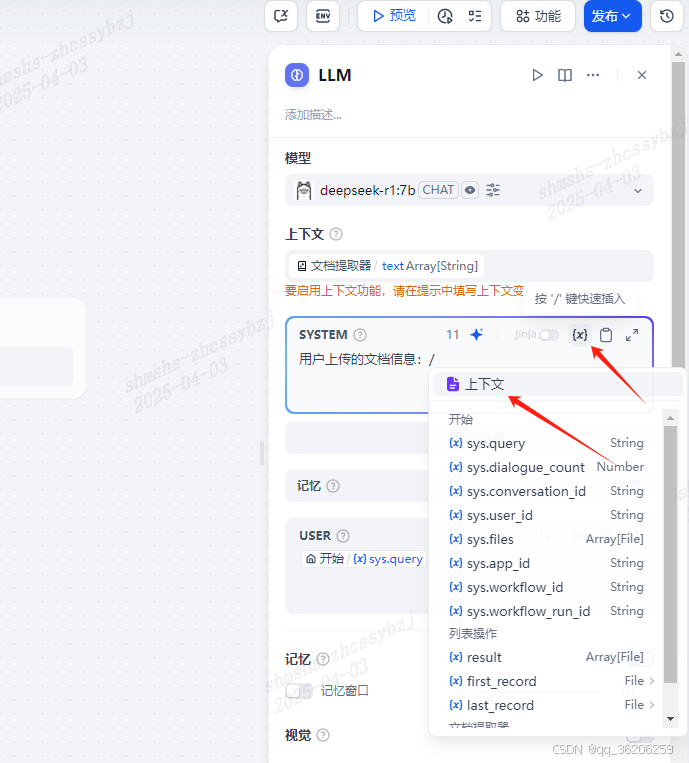

8. 更新LLM配置,分为5个步骤,见下图

1——选择模型 2——选择本地配置的模型,没有的话可以点击模型设置进行配置(可以参考文章后面的注意事项) 3——上下文选择文档提取器

1——选择模型 2——选择本地配置的模型,没有的话可以点击模型设置进行配置(可以参考文章后面的注意事项) 3——上下文选择文档提取器  4——SYSTEM配置为:【用户上传的文档信息:】+【上下文】 5——上下文配置见下图,最终效果见步骤8的1-5小标全景图

4——SYSTEM配置为:【用户上传的文档信息:】+【上下文】 5——上下文配置见下图,最终效果见步骤8的1-5小标全景图

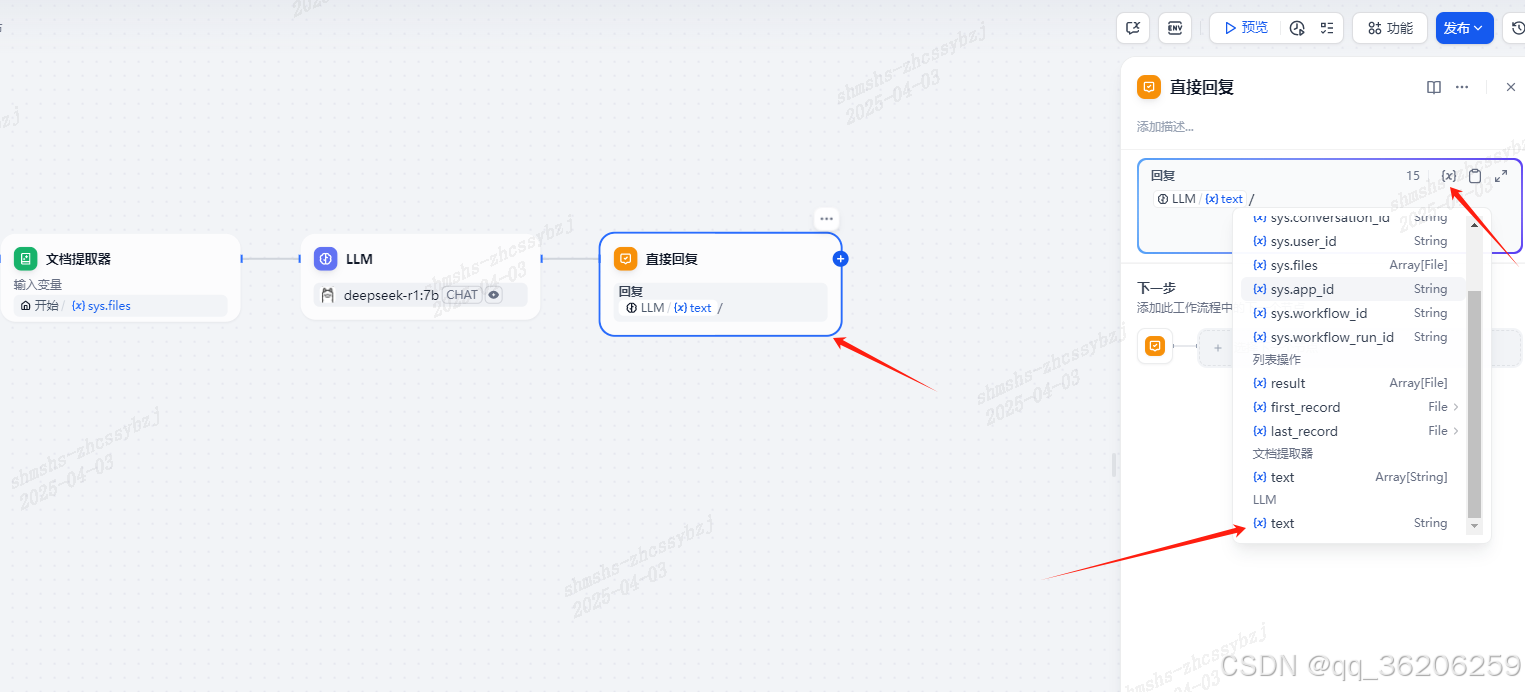

9. 配置直接回复

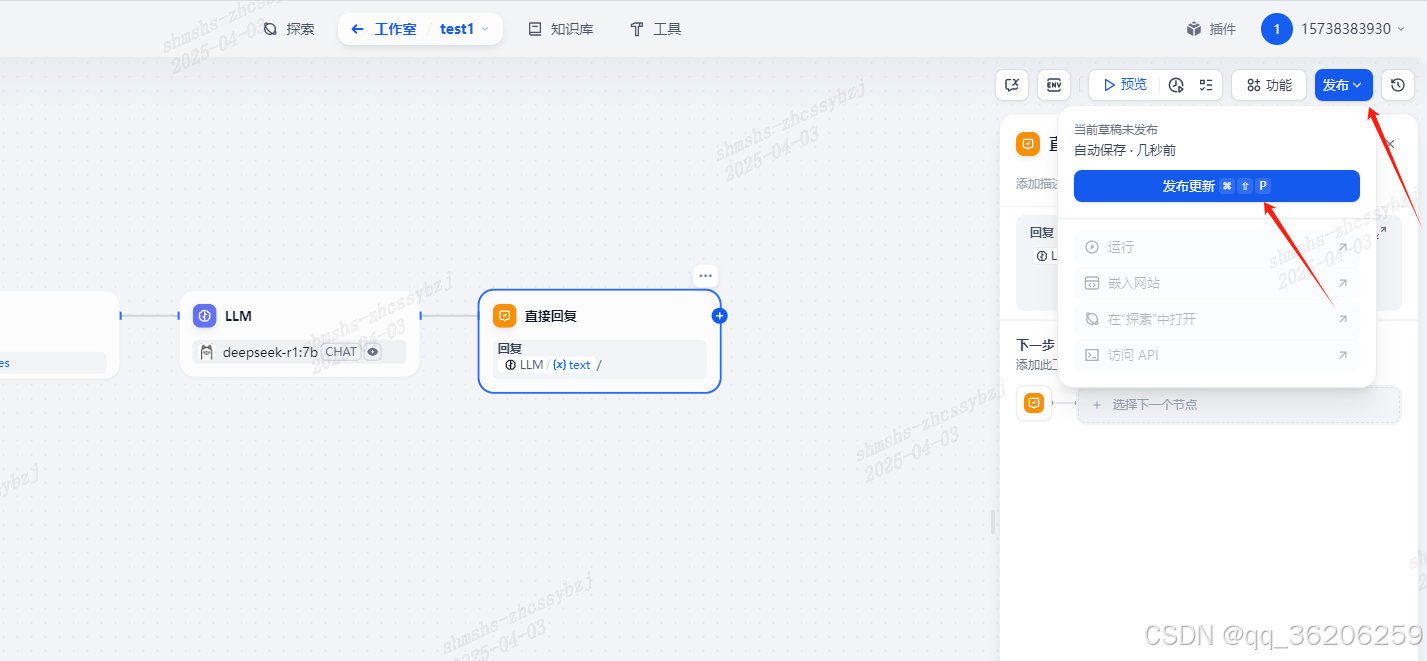

10. 发布更新

五、体验

注意事项

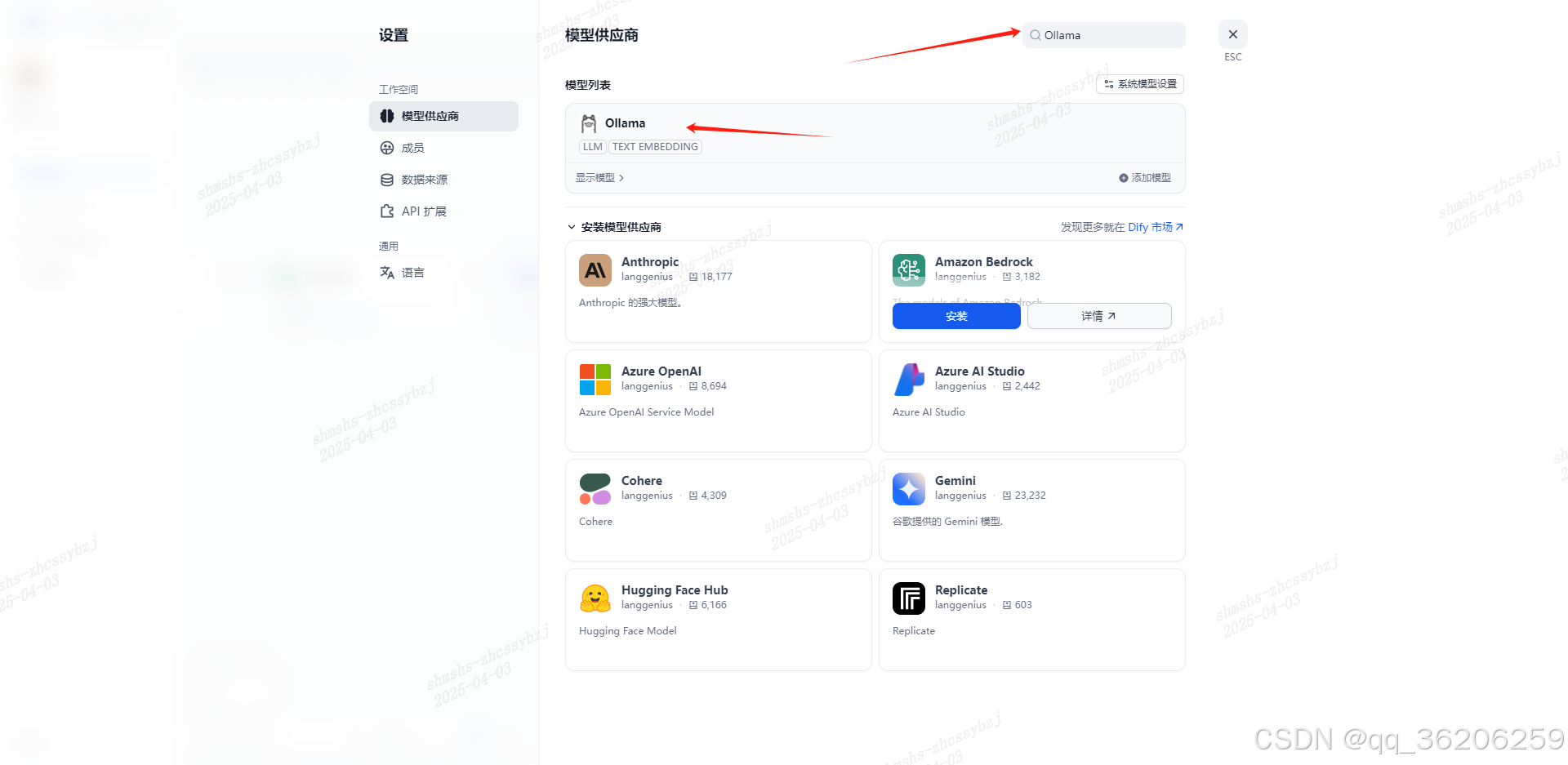

1. 关于LLM节点模型的配置

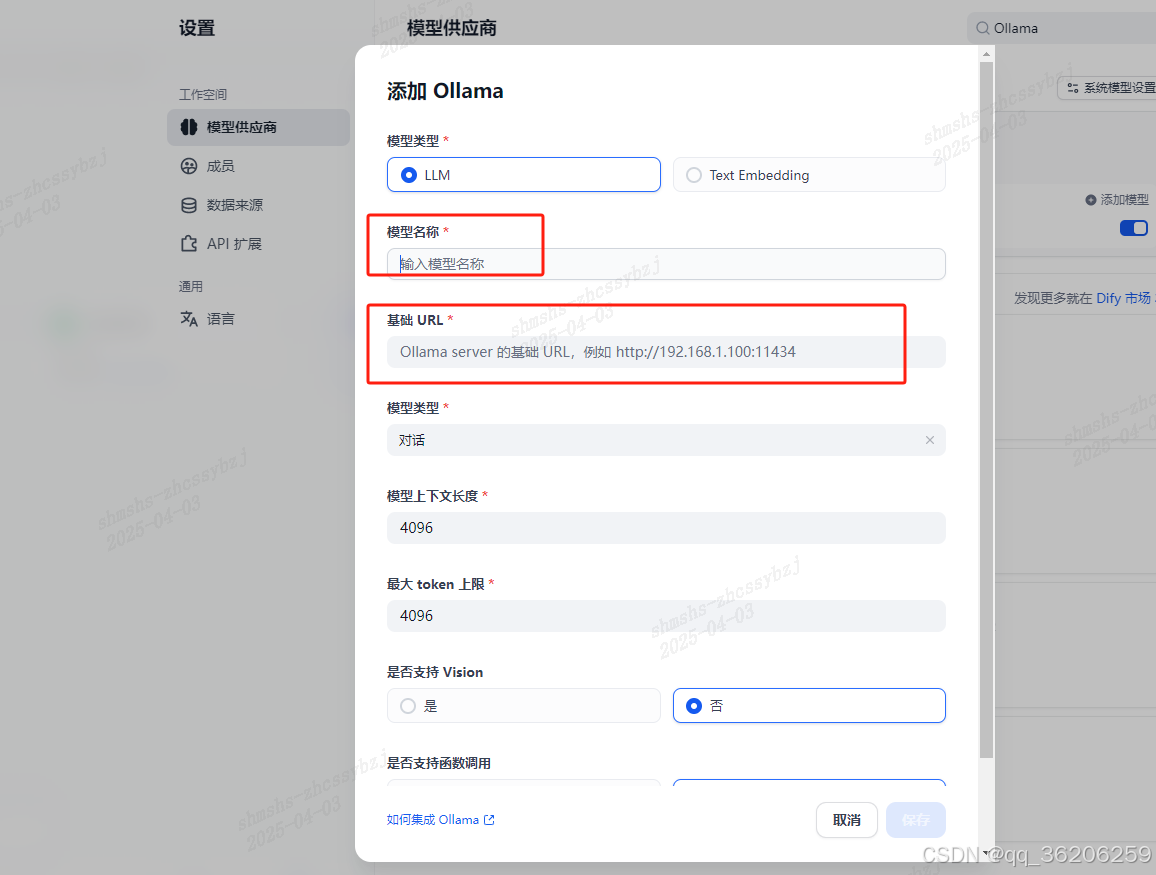

(1) 点击模型设置,安装Ollama供应商  (2)添加模型 模型名称——之前安装Ollama时选择的模型,名称填上去,例:deepseek-r1:7b 基础URL——http://ip:Ollama端口号 PS: 因本本文章安装Dify使用的是Docker,这里ip建议使用局域网 IP 地址,例如:192.168.1.100

(2)添加模型 模型名称——之前安装Ollama时选择的模型,名称填上去,例:deepseek-r1:7b 基础URL——http://ip:Ollama端口号 PS: 因本本文章安装Dify使用的是Docker,这里ip建议使用局域网 IP 地址,例如:192.168.1.100

(3)保存

(3)保存

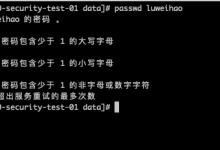

2. 保存模型时可能会遇到以下问题

httpconnectionpool (host=127.0.0.1, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError ('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool (host=localhost, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError ('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))

这时需要添加一个Ollama的环境变量配置 进入的Ollama的ollama.service所在目录

cd /etc/systemd/system/

sudo vi ollama.service

在[Service]部分下添加一行 Environment

[Service]

Environment="OLLAMA_HOST=0.0.0.0:Ollama端口号"

保存并退出,重启 Ollama

systemctl daemon-reload

systemctl restart ollama

以上操作完成后,再次保存模型,成功

参考链接

本地部署DeepSeek-R1(Dify对话框上传文件+本地知识库对话)

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册