LLMs之Dify:Dify的简介、安装和使用方法、案例应用之详细攻略

目录

Dify的简介

1、核心功能列表

2、特性比较

Dify的安装和使用方法

1、Dify的安装和启动

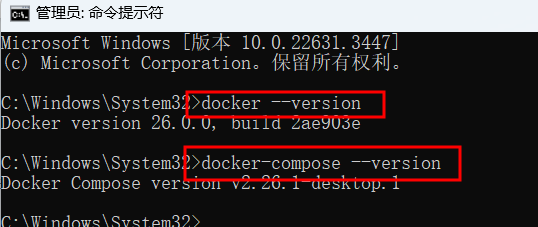

第1步,安装Docker和Docker Compose,参考A3、Windows11系统安装→交互式安装即可,一次性安装Docker和Docker Compose

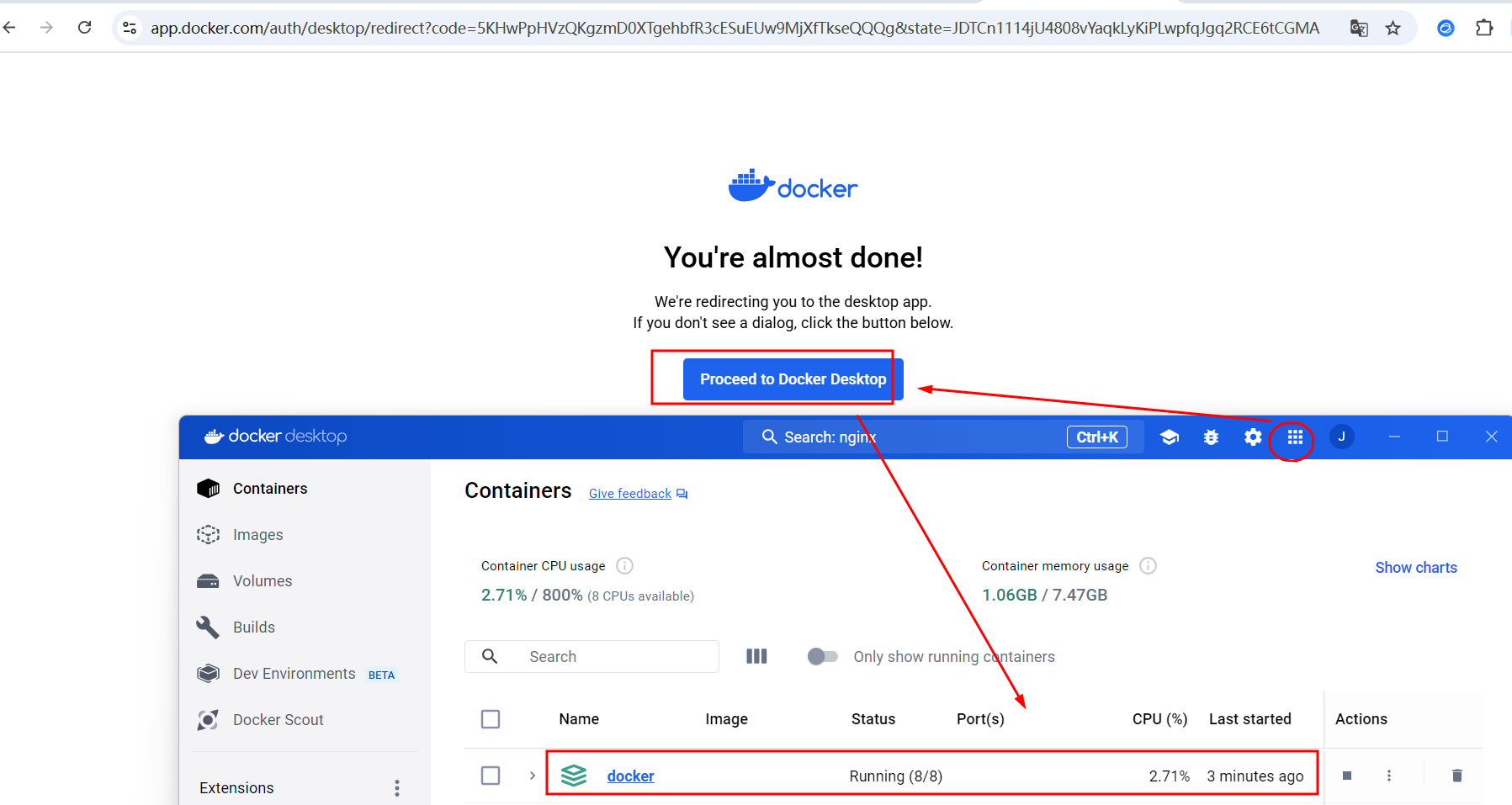

第2步,启动Docker服务容器,让其在后台运行

第3步,启动Dify服务并访问http://localhost/install

第4步,进入界面,设置邮箱、账号和密码

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3/Deepseek-r1等模型)结合Dify前端框架创建个性化应用—跨境电商客服/RAG本地知识库问答(设置知识库文件+向量化存储+应用发布)/翻译助手等多个应用

2、使用Dify:

T1、云端

T2、自托管Dify社区版:

T3、面向企业/组织的Dify:

Dify的案例应用

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3/Deepseek-r1等模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

Dify的简介

2023年5月,Dify正式发布,这是一个开源的LLM应用程序开发平台。它直观的界面结合了人工智能工作流程、RAG管道、代理能力、模型管理、可观察性特性等等,让您能够快速从原型到生产。

GitHub地址:GitHub – langgenius/dify: Dify is an open-source LLM app development platform. Dify's intuitive interface combines AI workflow, RAG pipeline, agent capabilities, model management, observability features and more, letting you quickly go from prototype to production.

1、核心功能列表

>> 工作流:在可视化画布上构建和测试强大的人工智能工作流程,利用以下所有功能以及更多功能。 >> 全面的模型支持:与数百个专有/开源LLM(Language Model)以及数十个推理提供商和自托管解决方案实现无缝集成,涵盖了GPT、Mistral、Llama3以及任何与OpenAI API兼容的模型。支持的模型提供商完整列表可以在这里找到。 >> 提示IDE:为制作提示、比较模型性能以及为基于聊天的应用程序添加其他功能(如文本转语音)提供直观的界面。 >> RAG管道:广泛的RAG功能,涵盖了从文档摄取到检索的所有内容,支持从PDF、PPT等常见文档格式中提取文本。 >> 代理能力:您可以基于LLM函数调用或ReAct定义代理,并为代理添加预构建或自定义工具。Dify提供了50多个用于AI代理的内置工具,如Google搜索、DELL·E、稳定扩散和WolframAlpha。 >> LLMOps:随着时间的推移监视和分析应用程序日志和性能。您可以根据生产数据和注释持续改进提示、数据集和模型。 >> 作为后端服务:Dify的所有功能都配备了相应的API,因此您可以轻松地将Dify集成到自己的业务逻辑中。

2、特性比较

| Programming Approach | API + App-oriented | Python Code | App-oriented | API-oriented |

| Supported LLMs | Rich Variety | Rich Variety | Rich Variety | OpenAI-only |

| RAG Engine | ✅ | ✅ | ✅ | ✅ |

| Agent | ✅ | ✅ | ✅ | ✅ |

| Workflow | ✅ | ❌ | ✅ | ❌ |

| Observability | ✅ | ✅ | ❌ | ❌ |

| Enterprise Feature (SSO/Access control) | ✅ | ❌ | ❌ | ❌ |

| Local Deployment | ✅ | ✅ | ✅ | ❌ |

Dify的安装和使用方法

1、Dify的安装和启动

|

硬件 |

在安装Dify之前,请确保您的计算机满足以下最低系统要求: CPU >= 2核 RAM >= 4GB |

|

启动 |

启动Dify服务器的最简单方法是运行我们的docker-compose.yml文件。在运行安装命令之前,请确保Docker和Docker Compose已安装在您的计算机上: docker –version docker-compose –version cd docker docker compose up -d # 这个命令会根据 docker-compose.yml 文件中的配置,创建并启动所有的服务容器,并且在启动后让这些容器在后台运行。 运行后,您可以在浏览器中访问http://localhost/install并开始初始化过程。 如果您想要为Dify做出贡献或进行额外的开发,请参考我们的部署指南 |

|

自定义 |

如果您需要自定义配置,请参考我们docker-compose.yml文件中的注释并手动设置环境配置。在进行更改后,请再次运行docker-compose up -d。您可以在此处查看完整的环境变量列表。 如果您想要配置高可用性设置,社区贡献的Helm Charts可以让Dify部署在Kubernetes上。 |

第1步,安装Docker和Docker Compose,参考A3、Windows11系统安装→交互式安装即可,一次性安装Docker和Docker Compose

docker –version

docker-compose –version

Docker:Docker的简介、安装、使用方法之详细攻略_docker 知乎-CSDN博客

第2步,启动Docker服务容器,让其在后台运行

第3步,启动Dify服务并访问http://localhost/install

e:

cd E:\\File_Python\\Python_NLP\\dify-main

cd docker

docker compose up -d

第4步,进入界面,设置邮箱、账号和密码

Tesla

jason******niu@gmail.com

new+Q9

第5步,登录账号后,设置模型以及应用等

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3/Deepseek-r1等模型)结合Dify前端框架创建个性化应用—跨境电商客服/RAG本地知识库问答(设置知识库文件+向量化存储+应用发布)/翻译助手等多个应用

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用_llama3本地化rag教程-CSDN博客

2、使用Dify:

T1、云端

我们为任何人提供了一个无需设置即可尝试的Dify云服务。它提供了自部署版本的所有功能,并包括沙箱计划中的200次免费GPT-4调用。

T2、自托管Dify社区版:

使用这个入门指南快速在您的环境中运行Dify。使用我们的文档以获取进一步的参考和更详细的说明。

T3、面向企业/组织的Dify:

我们提供额外的面向企业的功能。与我们安排会议或发送电子邮件讨论企业需求。

对于使用AWS的初创企业和小型企业,请查看AWS Marketplace上的Dify Premium,并使用一键部署到您自己的AWS VPC。这是一个价格实惠的AMI套餐,可选择使用自定义标志和品牌创建应用程序。

Dify的案例应用

持续更新中……

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3/Deepseek-r1等模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用_llama3本地化rag教程-CSDN博客

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册