目录

一、引言

二、硅基流动配置指南(10分钟极速版)

(1)硅基流动账号注册和获取密钥

(2)ChatBox客户端安装

(3)硅基流动服务端配置:一键调用满血模型

三、其他在线可用的平台(网页/应用)

腾讯元宝

国家超算平台智能助手

秘塔搜索

纳米搜索

四、总结

五、参考

一、引言

随着DeepSeek最近的爆火,其用户量已经呈指数级增长,在使用网页版时,经常会出现"服务器繁忙"的提示(统计据说是日均触发率高达70%),在高峰时段(14:00-22:00)单次响应延迟达到了15秒以上,这实在影响使用体验。为此,大家也都开始寻找本地部署或者其他的可替代方案。

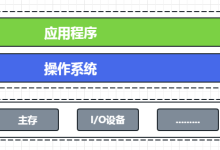

本地部署在硬件条件支持的情况下,可以解决卡顿的问题。需要进行本地部署可以点击这个教程链接:DeepSeek 本地化部署(保姆喂饭级教程) – 知乎,亲测可行。但是这个硬件成本对大部分人来说是有点太高了,对于R1深度思考的一个版本(通常说的满血版),671B模型需350GB显存,远超消费级显卡(如RTX 4090仅24GB),32B模型需至少4张A100(80GB),成本超30万元,性能也就接近GPT-3.5的样子,成本不够的话说不定就比网页版还要卡,毕竟大模型实在太吃电脑配置了。

这就体现出硅基流动配置的核心优势了:因为是在线配置好的服务器,不需要本地的硬件成本、价格低(按token计费,基本的版本0.12元/万token、配置超级简单(10分钟就可以搞定)而且还支持定制。

二、硅基流动配置指南(10分钟极速版)

(1)硅基流动账号注册和获取密钥

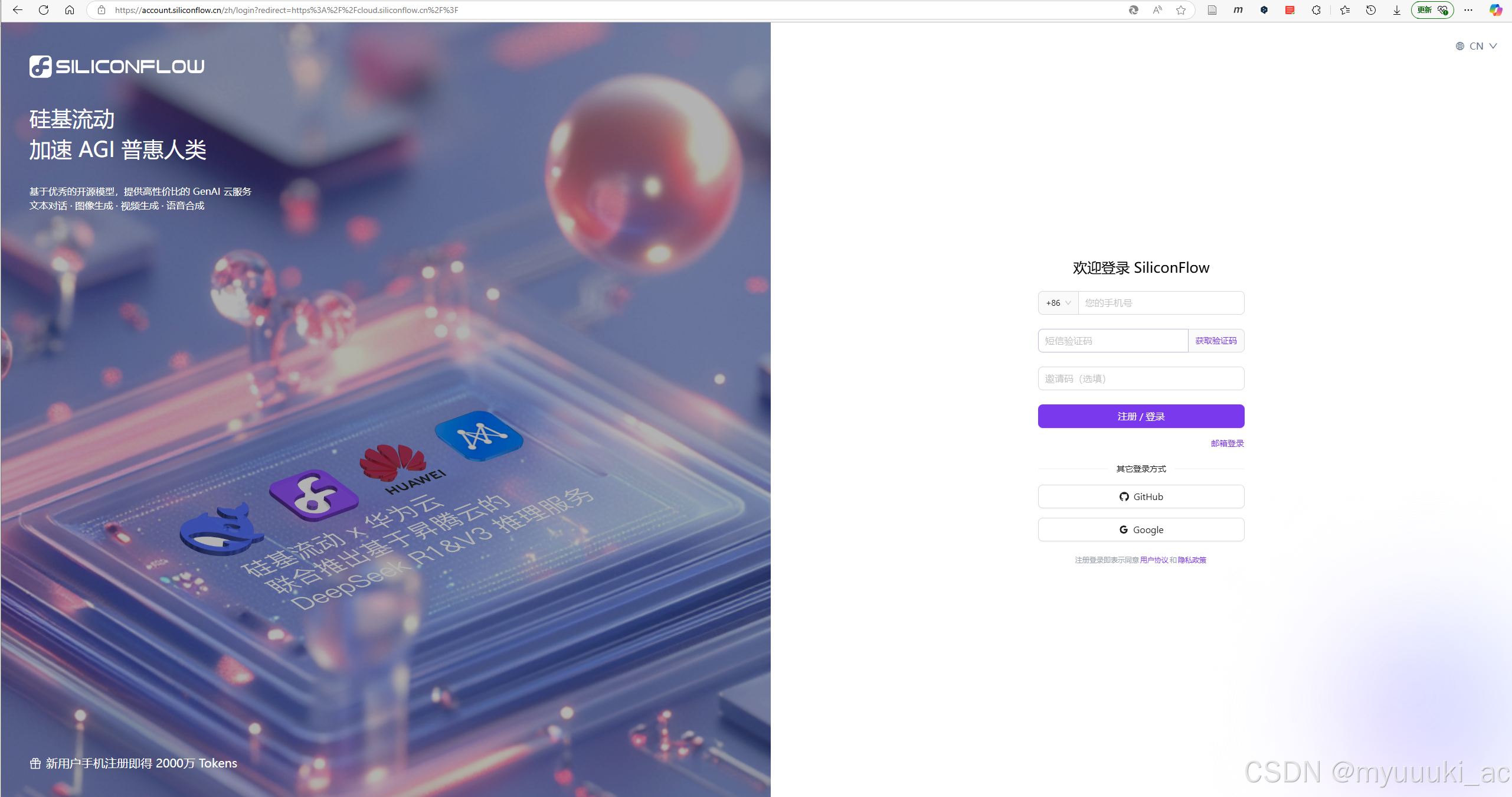

1. 首先,进入硅基流动的官网,按照页面提示进行注册。这里推荐大家在这个链接进行注册:硅基流动统一登录(使用邀请码,新用户注册即送 2000 万 Tokens,大概1万条回答)

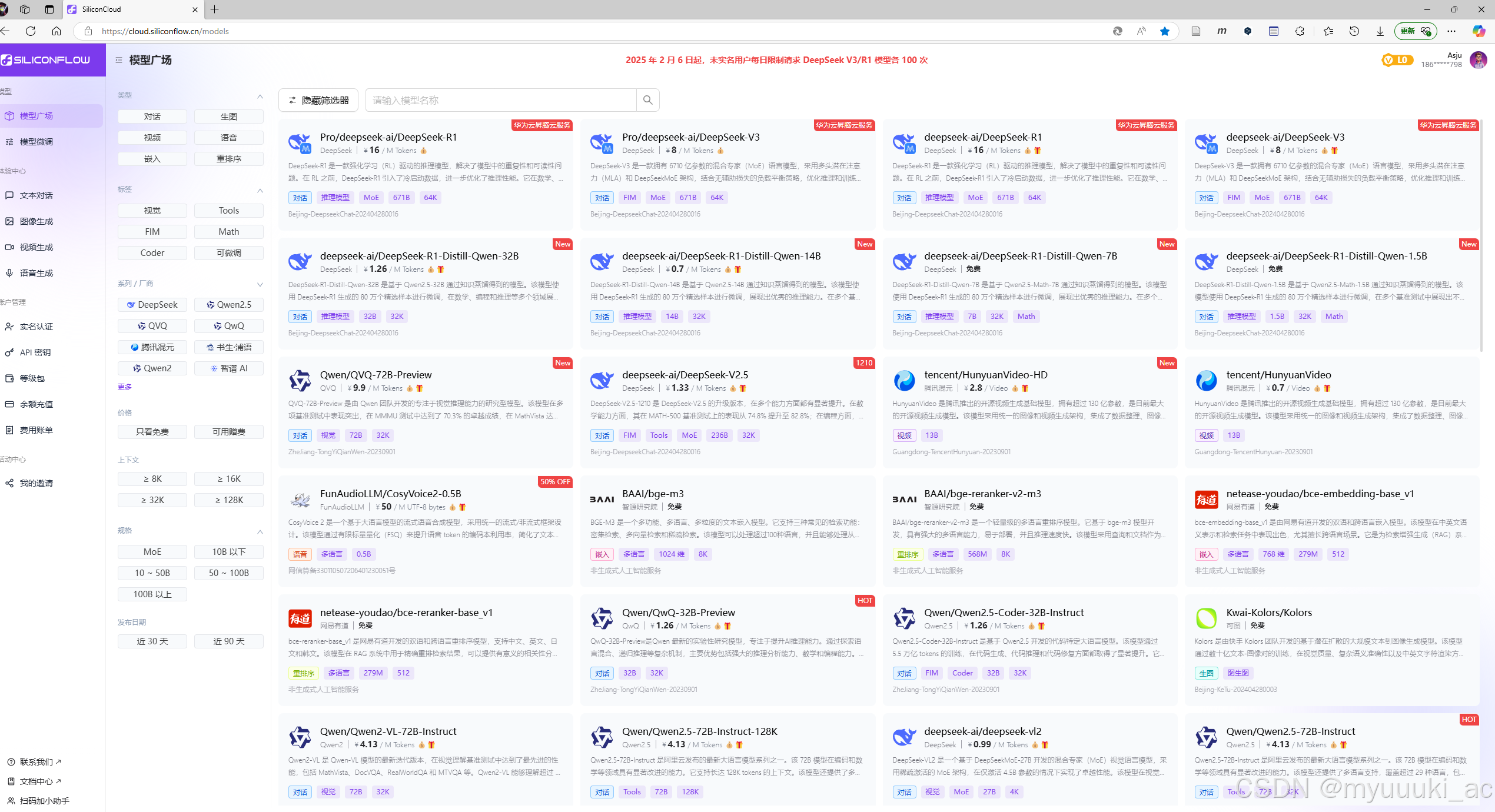

2. 注册成功之后进入网站主页,在模型广场有很多模型示例,大家可以按需进行选择。在体验中心也可以进行文本对话聊天,但是这里只是一个即时聊天,没有本地化保存我们搜索的数据的功能,因此我们等会需要下载ChatBox,这是一个和这些大模型进行API对接的管理工具,可以适配各种大模型API,支持定制和本地存储一键导出聊天数据等功能,十分适合长期使用。

3. 在右上角设置页完成个人实名认证,填个信息然后支付宝刷个脸就行(也可以先不进行实名,不过官网说不实名的话每天会限制R1等模型的使用次数,好像是30次)

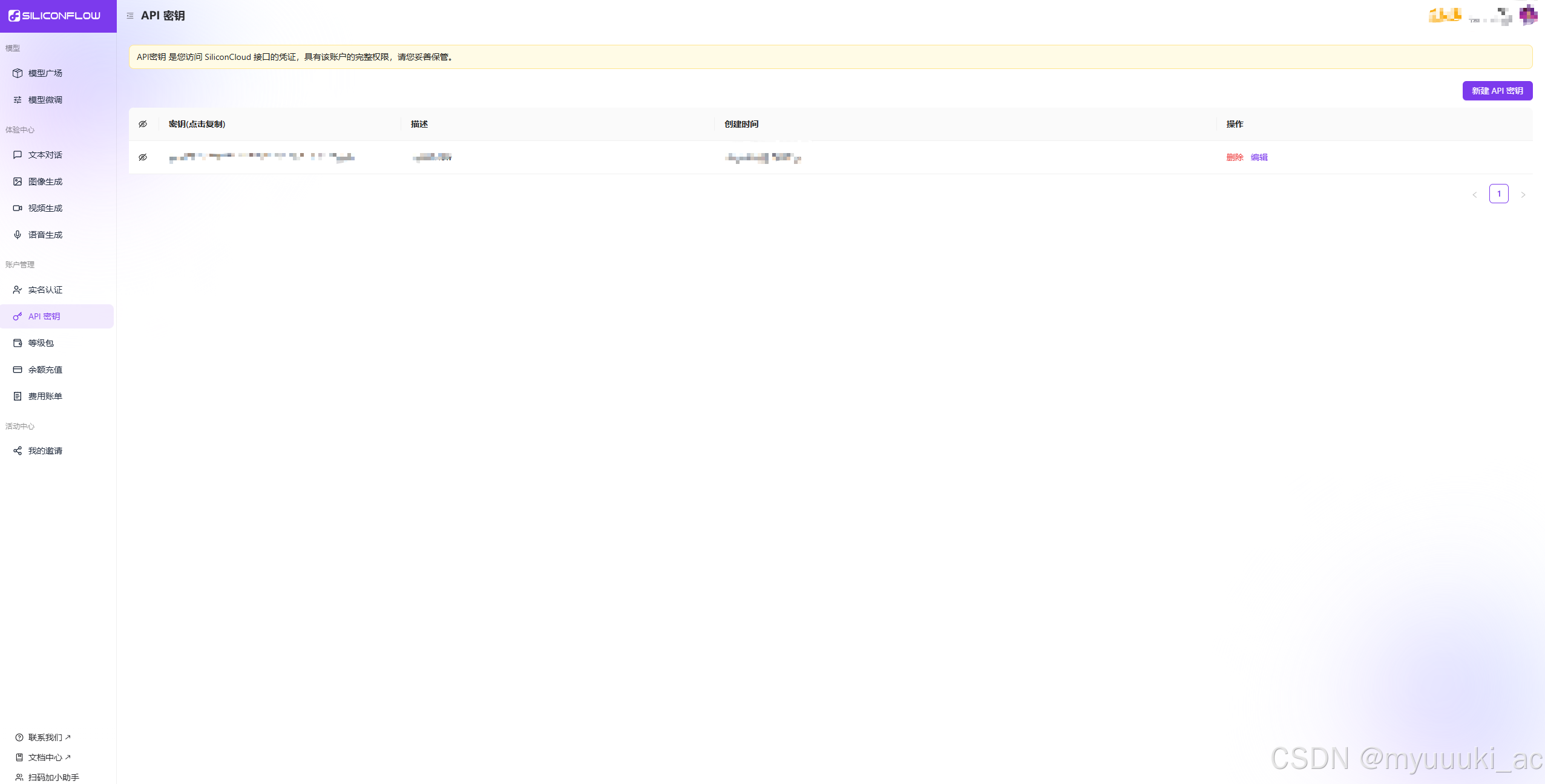

4. 在左边控制台点击「API密钥」的菜单,描述随便填,然后生成专属密钥(有效期为永久),复制到剪贴板。

(2)ChatBox客户端安装

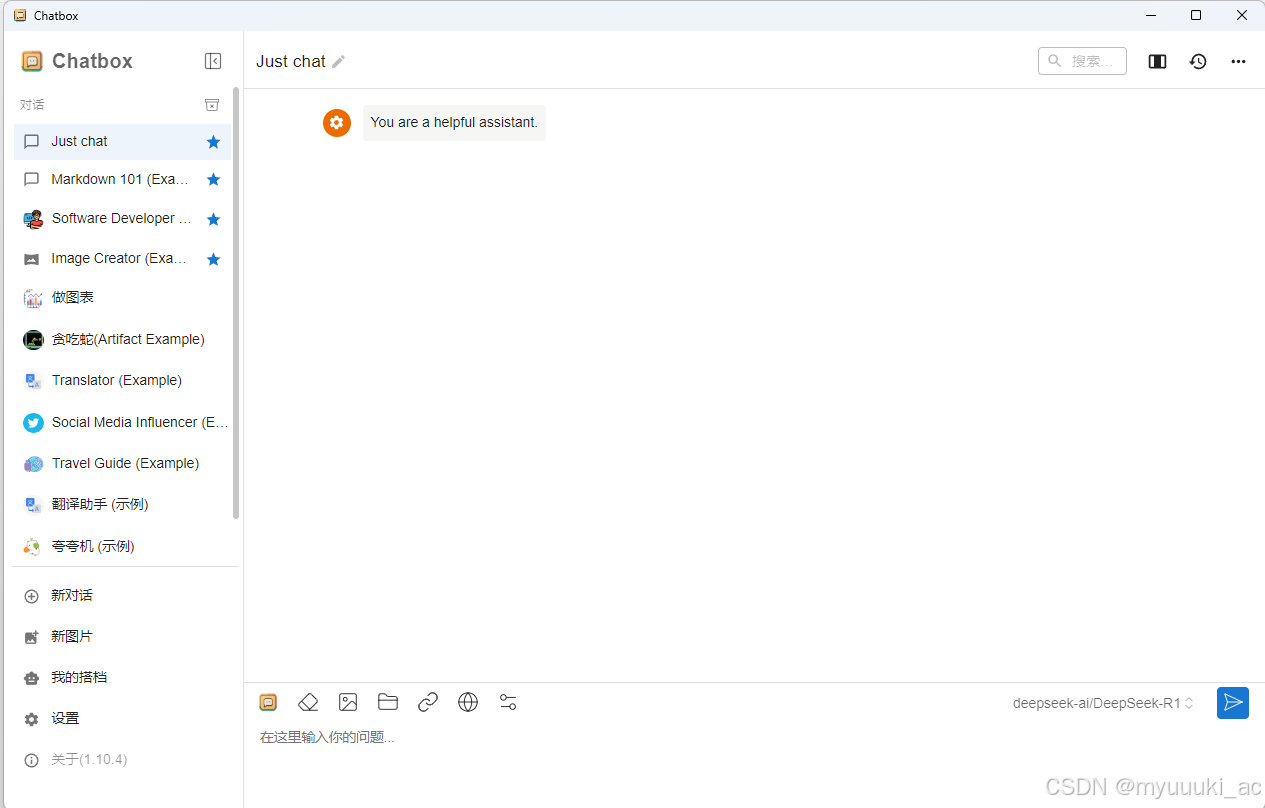

CharBox是一种API的线下软件,比较方便搜索,还可以本地化保存我们搜索的数据,根据自己设备的系统型号在官网Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载下载安装即可,安装完打开是这样:

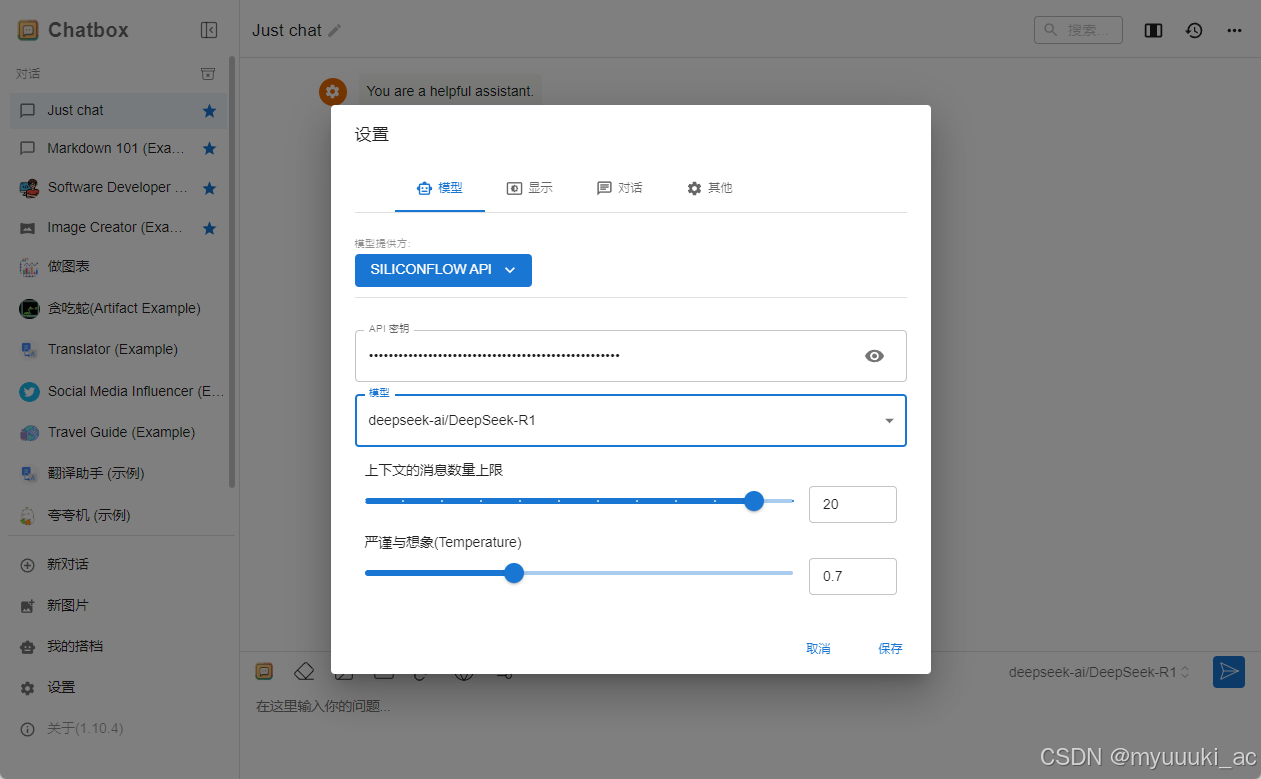

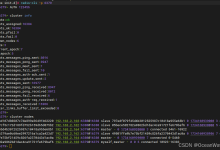

(3)硅基流动服务端配置:一键调用满血模型

我们下好ChatBox之后就可以进行API密钥配置了,点击左侧菜单栏的“设置”,然后配置模型信息,粘贴刚才生成的密钥,模型选择R1,保存之后就可以开始使用了。

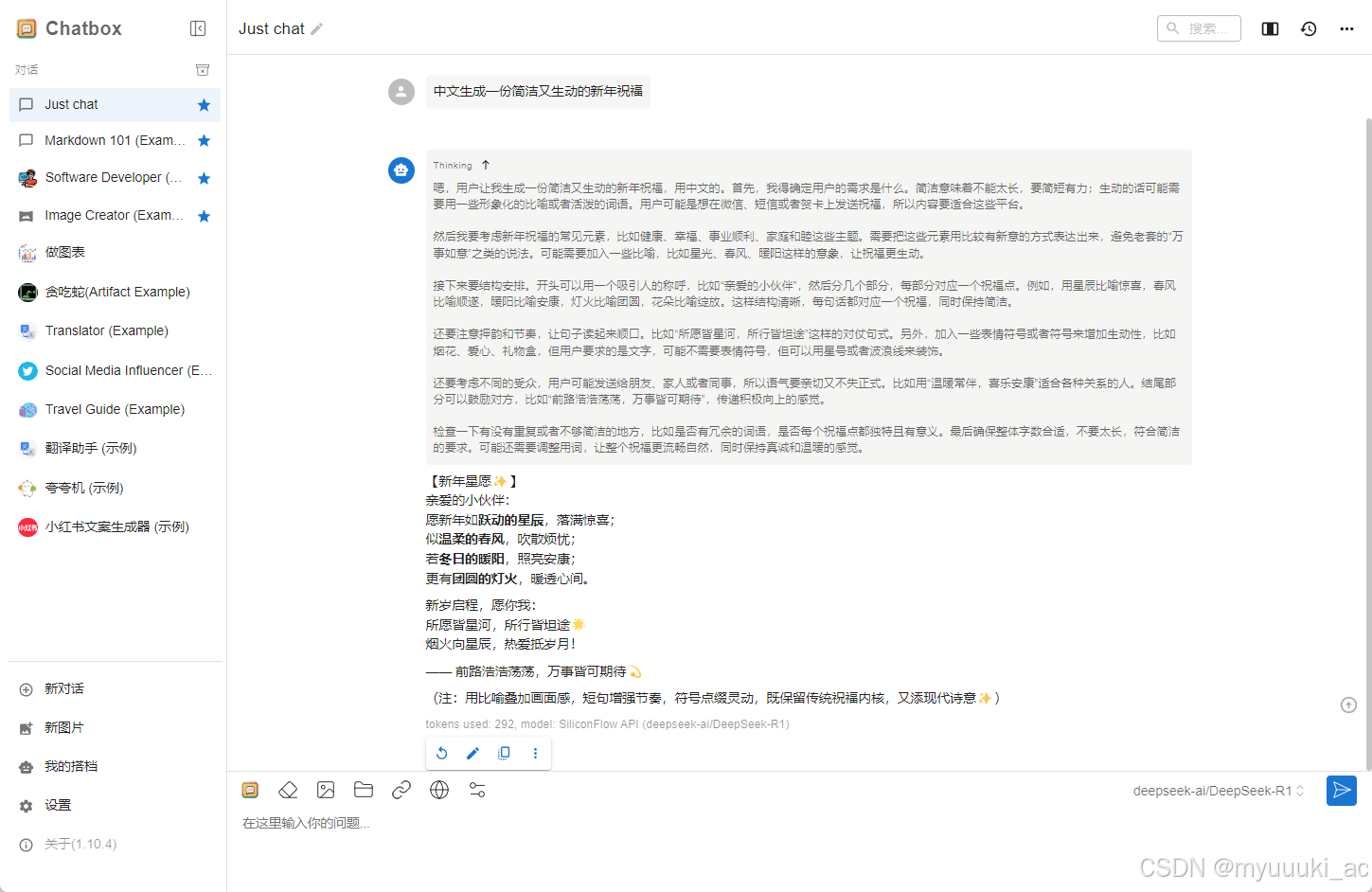

下面是一个简单的连接测试,可以验证是否正常部署,我们通过“新年祝福生成”指令来验证响应速度与稳定性,经过测试,速度还是比官方网页版可观一些的。

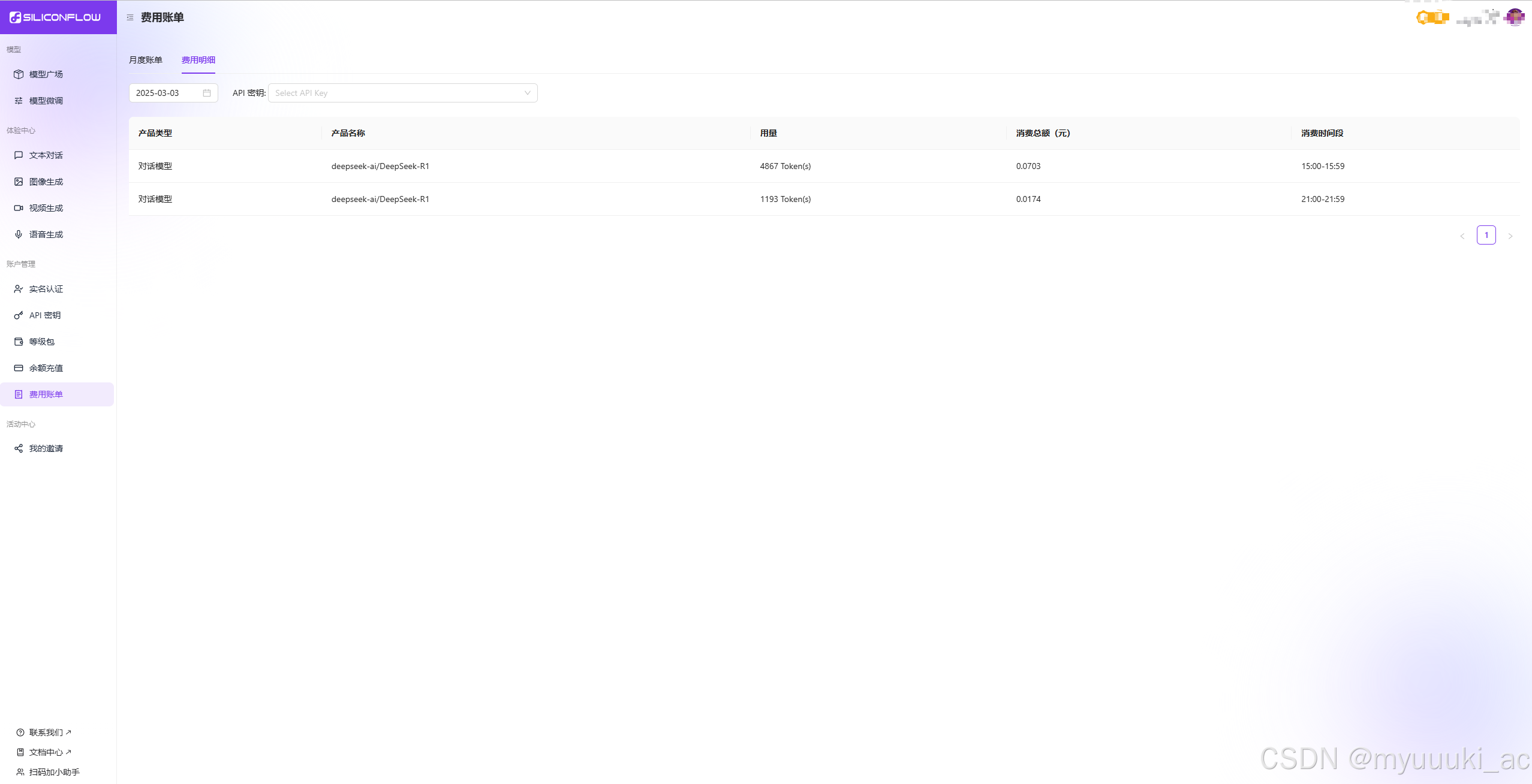

最后,可以定期在硅基流动官网查看每次对话完之后token费用账单以及余额,1193tokens平均消费¥0.0174,价格还是比较人性化的,注册送的14元也够用一段时间了。

三、其他在线可用的平台(网页/应用)

当然,如果实在懒得配置或者是急着使用,也推荐一些其他的可替代网页,卡顿没有官方那么严重,但是相对来说功能没那么强大,界面也可能不咋好看,长期使用的话还是更推荐硅基流动的配置和部署。

腾讯元宝

网页链接:腾讯元宝 – 轻松工作 多点生活

最推荐这个,它的回答展示UI做的很不错,几乎可以约等于DeepSeek官网了,不过腾讯元宝免费版限每日50次请求,需要及时监控Token消耗。

国家超算平台智能助手

网页链接:智能助手

这个支持DeepSeek R1深度思考,使用起来也还挺方便的。

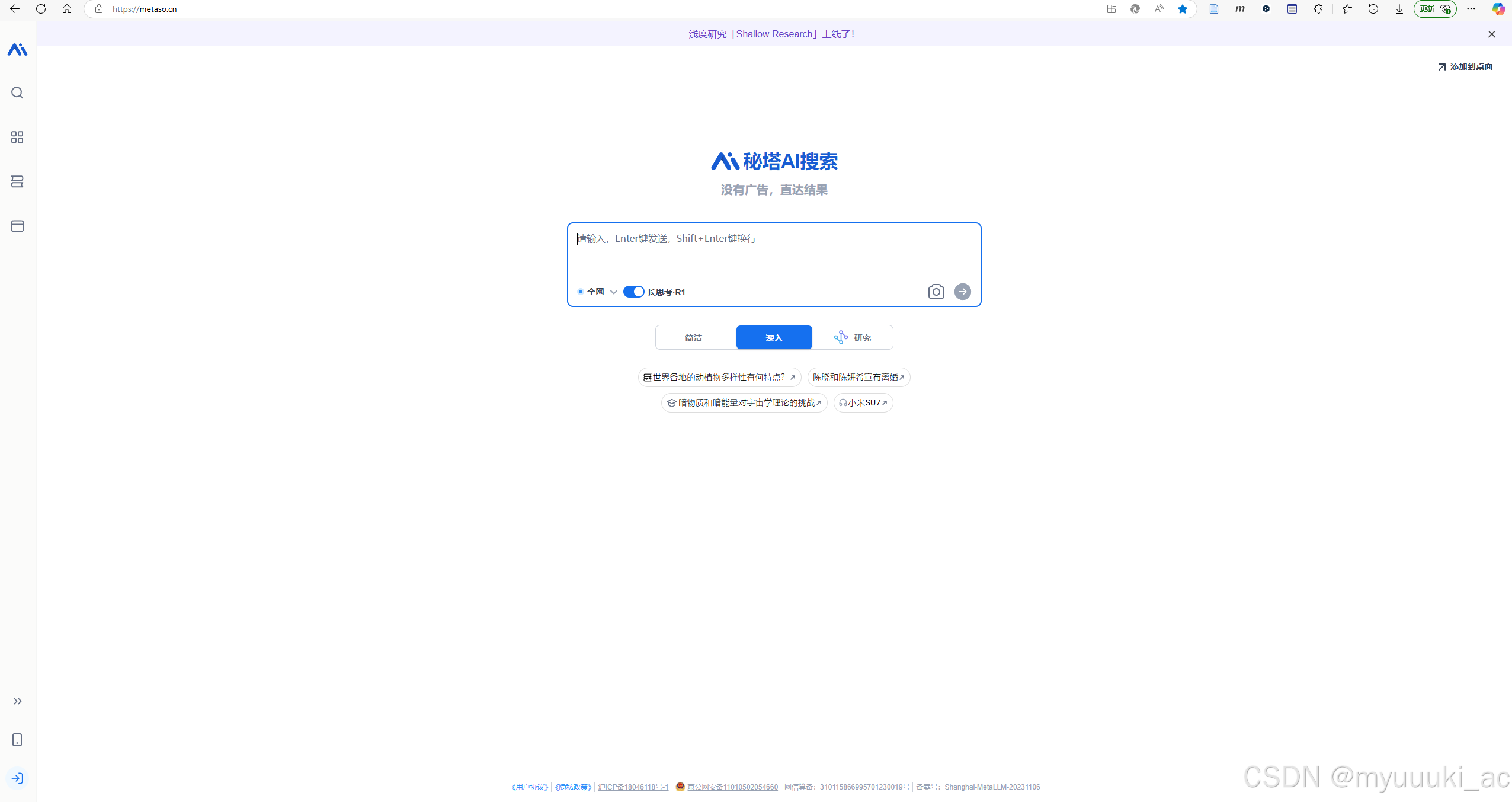

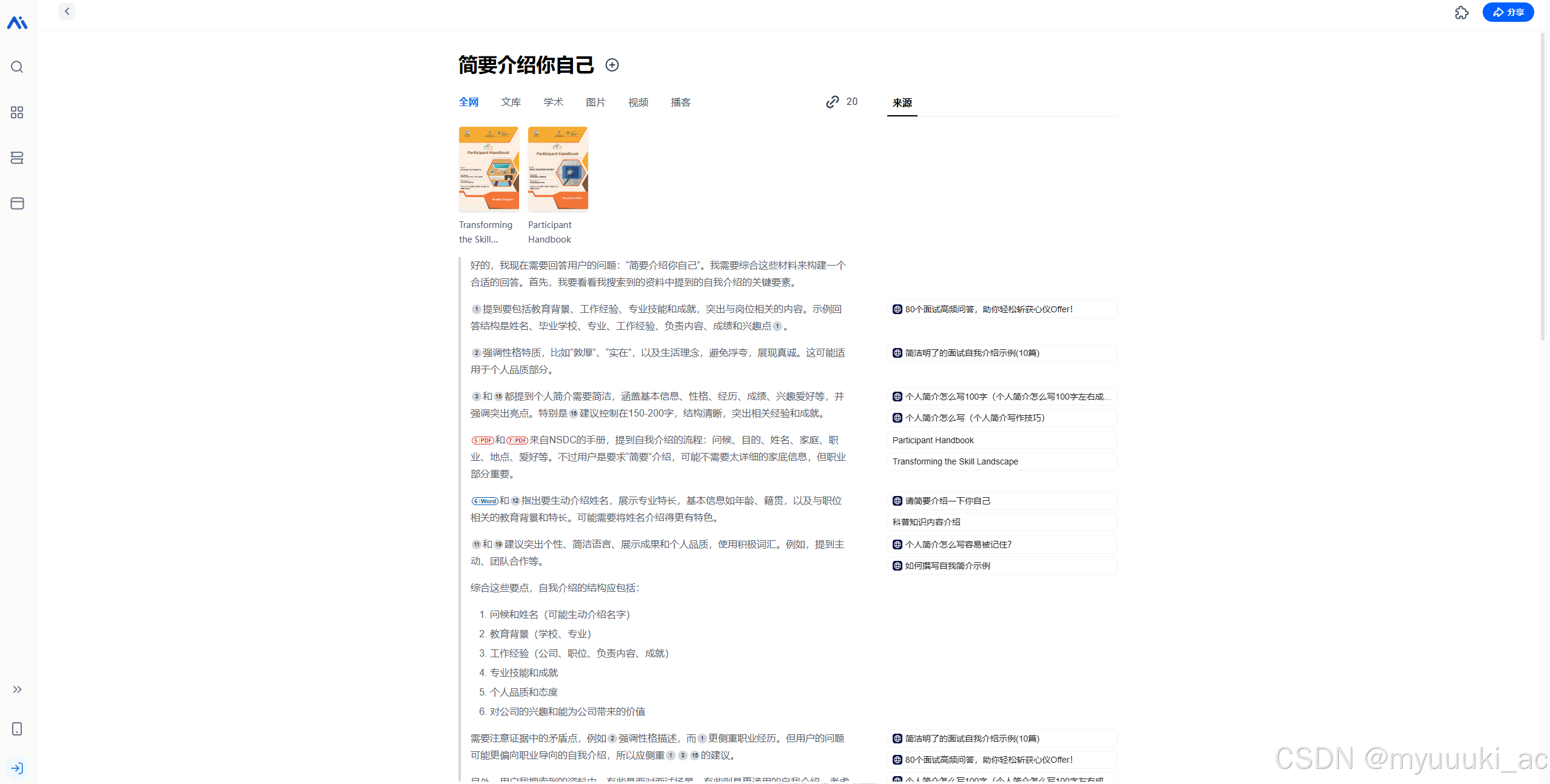

秘塔搜索

网页链接:秘塔AI搜索

这个支持DeepSeek R1深度思考,完成注册就可以聊天了,它搜集中文的文献能力是很不错的,不过没有办法使用离线模式。

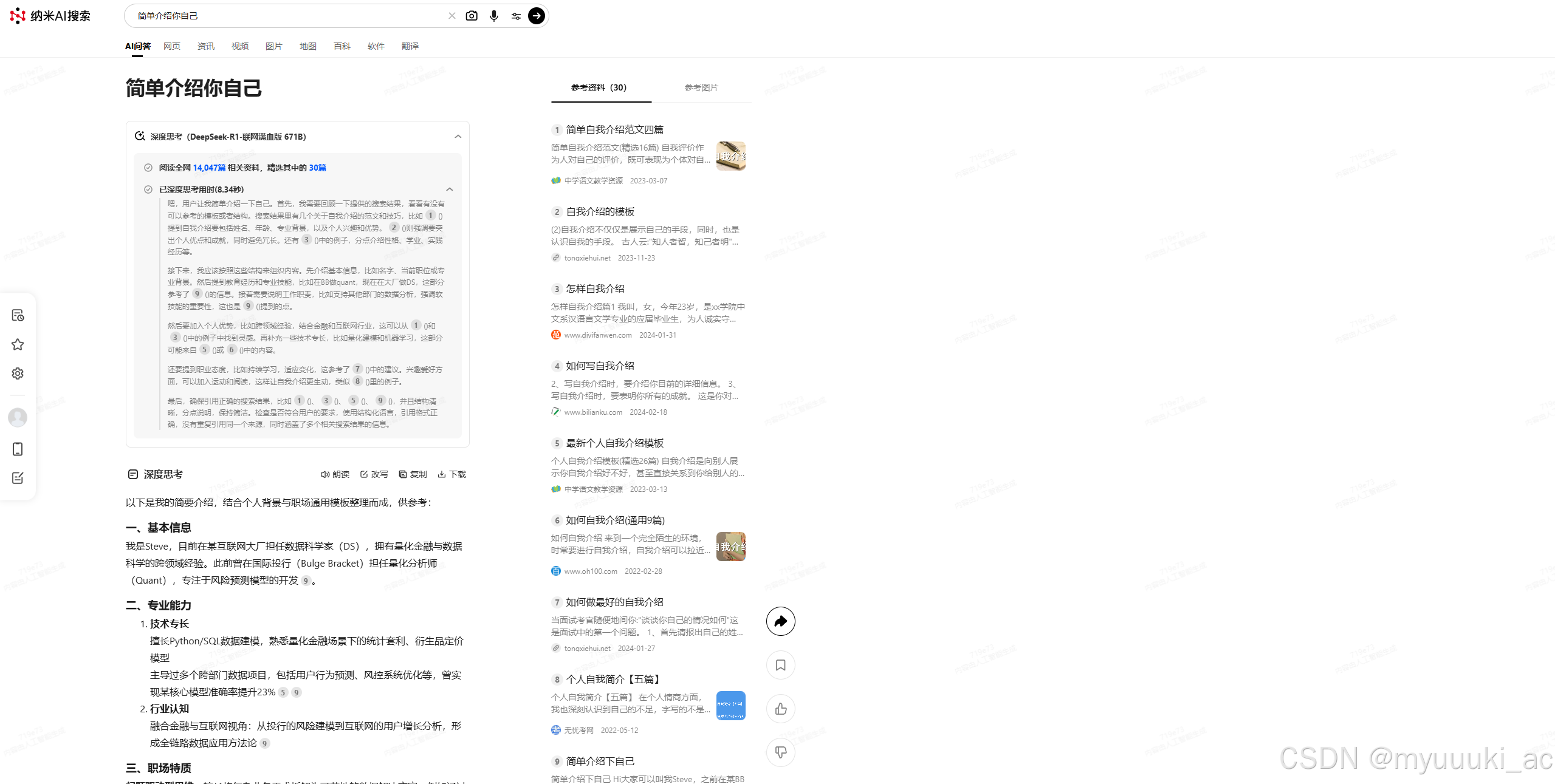

纳米搜索

网页链接:纳米AI搜索

这个也支持DeepSeek R1深度思考,用户每日有20次免费额度,但是我用起来展示界面感觉不是很习惯,像个很一般的搜索引擎。

四、总结

- 短期方案:优先选择硅基流动API,成本低、响应快,适合开发者与小规模应用。

- 长期方案:可以利用腾讯元宝(集成生态+多模态功能) + 硅基流动(定制化需求),形成混合架构(在线+本地)。

五、参考

-

产品简介 – SiliconFlow

-

腾讯元宝 | AI工具箱

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册