前言

DeepSeek 作为国产开源大模型,近期因在线服务压力过大,本地部署需求激增。本教程将结合全网优质资源,手把手教你完成从环境配置到交互界面搭建的全流程,即使是零基础用户也能轻松掌握。

为什么要部署本地 DeepSeek?

在本地部署 DeepSeek 有以下几个优势:

隐私性高:数据都在本地运行,无需上传到云端,避免数据泄露风险。

稳定性强:不受网络波动影响,模型运行更加稳定。

可定制性强:可以根据需求调整模型参数,满足个性化需求。

一、部署前准备

1.1 登录与注册

具体见:DeepSeek&使用指南

1.2 硬件要求

二、开始部署

2.1 ollama下载

首先进入Ollama官网 → 选择相应的版本进行下载

本文选择的是Windows系统,所以以下案例针对Windows系统展开。接下来选择Windows 进行下载。

2.2 ollama部署到其它盘

在安装 Ollama 时,使用命令行工具(例如 Windows 的 命令提示符 或 PowerShell)并加上 /DIR 参数来指定安装路径。具体步骤如下:

下载 Ollama 安装包: 首先,您需要从 Ollama 官网 https://ollama.com/download 下载 Windows 版本的安装包 OllamaSetup.exe。

打开命令提示符或 PowerShell: 在 Windows 搜索栏中输入 cmd 或 powershell,然后选择 “以管理员身份运行” 打开命令提示符或 PowerShell。

运行安装命令: 在命令提示符或 PowerShell 中,使用 cd 命令切换到您下载的 OllamaSetup.exe 文件所在的目录。例如,如果您的安装包下载到了 D:/ollama 文件夹,则输入以下命令并回车:

cd ~

cd D:/ollama

.\\OllamaSetup.exe /DIR="D:\\Ollama"

以上只是将应用程序安装到了D盘,下载模型时依旧会下载到C盘,所以接下来我们进行环境配置:

打开系统"环境变量" :

在 Windows 搜索栏中输入 “环境变量”,选择 “编辑系统环境变量”。

在弹出的 “系统属性” 窗口中,点击 “环境变量” 按钮。

添加或修改 “OLLAMA_MODELS” 环境变量:

在 “系统变量” 或 “用户变量” 区域中,点击 “新建” (如果不存在 OLLAMA_MODELS 变量) 或选中 OLLAMA_MODELS 变量并点击 “编辑” (如果已存在)。

变量名: 输入 OLLAMA_MODELS (请确保全部大写)。

变量值: 输入您希望模型文件存储的路径

点击 “确定” 保存更改。

注意: 如果您之前没有设置过 OLLAMA_MODELS 环境变量,则需要在 “系统变量” 或 “用户变量” 区域中点击 “新建” 来创建。如果您已经设置过,则需要选择 “编辑” 来修改变量值。

最后,只需重启ollama或者重启电脑即可。这样子就能够帮您的C盘省下很多的空间啦

接着deepseek的部署同Deepseek服务器繁忙? 一键本文给你解决

2.3 ollama网站无法打开及无法下载问题:

2.3.1 从GitHub上进行下载

从github官网(https://github.com/)上搜所ollama,找到我图片中箭头显示的Release:

点击跳转到Release版本

在下面Assets的地方找到你想下载的版本,然后github下载也比较慢,可以用这个github加速

打开这个网站:https://github.moeyy.xyz/

2.3.2 GitHub打不开问题解决

一、通过绕过DNS解析,直接在本地host。在浏览器中打开DNS查询网站[http://tool.chinaz.com/dns],输入github.com,查找ttl时间最小的

二、需要在host文件里修改

打开C:\\Windows\\System32\\drivers\\etc\\hosts

在hosts文件后面新增响应ip

接着打开命令行窗口 win + R

输入指令: ipconfig /flushdns

之后就可以打开github官网了

2.3.3 可以复制他人已经安装好的模板

2.3.3.1 在电脑A上找到模型位置并复制模型文件

在Ollama的模型存放目录下,有两个文件夹,一个叫blobs,另一个叫manifests。

blobs文件

这里有很多文件,很难去找

方法就是去Ollama的模型库里,找到你之前下载的模型,比如我要找glm4的,就先去到glm4的介绍页:glm4,然后点击model

在模型页上找到这串代码

接着去文件夹里复制

manifests文件

这个文件夹就简单多了,因为点进去还有两层,叫【registry.ollama.ai/library】,再进去会看到各个模型的名称:

把相应的复制出来即可

2.3.3.2 在电脑B上部署ollama环境

这里安装可以参考:Deepseek服务器繁忙? 一键本文给你解决

接着就是把以上两个文件夹以下面的格式复制过去

最后就是在电脑B上测试

ollama list

ollama run glm4

至此就将模型给复制完成啦!!!

2.4 验证下载是否成功

组合键 win + R 来打开命令窗口,输入以下指令

如有版本号显示,说明成功下载。

2.5 选择Deepseek模型

ollama安装成功后,在官网搜索deepseek,选择deepseek-r1,如下图所示。

to: deepseek参数选择

大多数电脑可以选择7b进行操作,本文将选择7b进行操作,运行以下代码

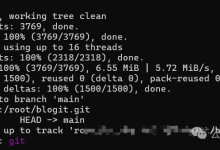

等待下载成功后,进行以下验证:

以上就代表本地部署成功。

三、将Deepseek客户端化

许多客户认为,使用命令行进行对话很麻烦,所以我们用UI工具与其进行交互

Chatbox使用案例

这里我们使用Chatbox来示范

首先进入Chatbox官网:Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

安装好后,就是将DeepSeek配置到Chatbox了,如下图:

配置 AI 模型提供方,这里选择 Ollama,如图:

选择deepseek模型

配置完成后,就可以在本地和deepseek进行互动,如下图:

四、其它渠道使用deepseek

4.1 硅基流动

网址: https://cloud.siliconflow.cn/i/uzRc32V4

特点:部署了多款开源模型,几乎能体验所有常见的大模型。提供免费的“小模型”版本,以及 DeepSeek R1 满血模型,但速度会略慢一些。目前平台还不支持联网搜索能力,输出纯基于本地模型推理。

4.2 秘塔搜索

网址: https://metaso.cn/

特点:早期就主打 AI 搜索概念,会先聚合网络内容,再结合 DeepSeek R1 模型进行思考与回答。搜索能力比单纯的 R1 模型更丰富,但也存在无法关闭联网搜索的限制。

4.3 纳米搜索 APP

网址: https://www.n.cn/

特点:网页端主要提供基础模式,纳米 APP 里才可以指定 R1 模型路线,稳定性较佳。慢思考模式能够让大模型在回答前进行更详细的推理。

4.4 国家超算互联网平台

网址: https://chat.scnet.cn/

特点:无需下载、无需登录就能免费使用,界面体验也比较好,唯一的缺点就是只支持32B。

4.5 英伟达NIM

网址: https://build.nvidia.com/deepseek-ai/deepseek-r1

特点:可直接通过网页版进行免费使用,响应挺快的,可展开折叠思考过程,代码也能看到对应的内容。

跋言

通过以上步骤,你已经成功地在本地部署了 DeepSeek 模型,并进行了简单的推理。本地部署 DeepSeek 可以让你更好地控制数据隐私和模型使用,同时也能根据自己的需求进行定制化开发。希望本文的指南能够帮助你顺利完成 DeepSeek 的本地部署,开启属于你自己的大模型之旅。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册