使用vLLM部署自己的AI聊天服务器:从入门到实践

1. 引言

在AI技术快速发展的今天,拥有一个自己的AI聊天服务器不仅能满足个性化需求,还能在保护隐私和控制成本方面带来巨大优势。vLLM(Versatile Large Language Model)作为一个高性能的大语言模型服务框架,为我们提供了一个绝佳的选择。本文将详细介绍如何使用vLLM部署一个兼容OpenAI API的AI聊天服务器,让你能够轻松地将其集成到现有的应用中。

2. vLLM简介

vLLM是一个用于大语言模型服务的高性能框架。它的主要特点包括:

3. 安装和配置vLLM

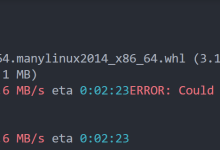

3.1 安装vLLM

首先,我们需要安装vLLM。推荐使用pip进行安装:

pip install vllm

3.2 下载模型

为了运行vLLM服务器,你需要下载一个预训练的语言模型。以Hugging Face的mosaicml/mpt-7b模型为例:

huggingface-cli download mosaicml/mpt-7b

4. 启动vLLM服务器

使用以下命令启动vLLM服务器:

python -m vllm.entrypoints.openai.api_server \\

–model mosaicml/mpt-7b \\

–host 0.0.0.0 \\

–port

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册