Web服务器的性能评估

Web服务器的性能评估是评定服务器承载能力和效率的重要手段。以下是Web服务器性能评估的关键指标、评测方法和常用的性能评估工具。

1. 关键性能指标

- 最大并发连接数:服务器同时处理的最大连接请求数。

- 响应延迟:服务器响应客户端请求所需的时间。

- 吞吐量:单位时间内服务器处理的请求数量。

2. 评测方法

- 基准性能测试:通过运行一系列预定测试来评估服务器性能的基线。

- 压力测试:通过增加负载直到服务器达到崩溃点来测试其性能极限。

- 可靠性测试:长时间运行在高负载下测试服务器的稳定性和可靠性。

3. 系统检测

- 系统本身提供的命令:通过操作系统提供的命令行工具来监控性能指标,如Linux的top、vmstat。

- 系统记录文件:通过分析系统日志文件来诊断性能问题,如/var/log/messages。

- 集成监控工具:使用第三方监控软件或集成解决方案来实时监控服务器状态,如Nagios、Zabbix。

4. 常用性能评估工具

- Apache AB:开源的命令行工具,用于进行基准测试和性能测试。简单易用,使用命令行界面,轻量级,快速高效。

- Apache JMeter:开源的Java框架,支持多种协议,如HTTP、HTTPS、FTP、JDBC等。提供图形化界面和可视化报告,支持分布式测试。

- Webbench:开源的基于Linux的Web服务器性能测试工具,能够模拟多用户并发请求以评估服务器性能。操作简单,执行快速,结果直观。

- Locust:基于Python的开源负载测试工具,支持HTTP和WebSocket协议。使用Python代码编写测试脚本,提供实时监控和报告功能。

- LoadRunner:商业性能测试工具,支持多种应用程序和协议,提供详细的性能分析报告。

- Gatling:现代化的开源性能测试工具,专为易用性和高性能而设计。支持HTTP、WebSocket等协议,实时结果分析和详细报告功能。

- K6:现代化、开发者友好的性能测试工具,使用JavaScript编写测试脚本。支持HTTP/1.1、HTTP/2和WebSocket协议,低资源消耗。

- Tsung:高性能、多协议的性能测试工具,支持HTTP、WebDAV、SOAP等多种协议。具有出色的并发处理能力,支持分布式测试。

通过以上指标、方法和工具,可以全面评估Web服务器的性能,从而优化服务器配置,提升用户体验。

Web服务器的性能评估是优化系统架构、提升用户体验的关键环节,需从性能指标、评估工具、影响因素、优化方向等多维度综合分析。以下是详细说明:

一、核心性能指标

1. 吞吐量(Throughput)

- 定义:单位时间内处理的请求数或数据量(如请求数/秒、字节/秒)。

- 意义:衡量服务器处理能力的核心指标,受CPU、内存、网络带宽等资源限制。

2. 响应时间(Response Time)

- 定义:从客户端发起请求到服务器返回完整响应的时间(包括网络传输、处理逻辑、数据库查询等)。

- 分类:

- 平均响应时间:所有请求的平均耗时。

- 95%响应时间:95%的请求在该时间内完成,反映长尾延迟。

- 目标:通常需控制在几百毫秒内(如电商场景要求≤500ms)。

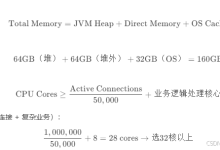

3. 并发连接数(Concurrent Connections)

- 定义:服务器同时处理的客户端连接数。

- 相关指标:

- 最大并发数:服务器能稳定处理的最大连接数,超过后可能导致请求排队或崩溃。

- 连接数峰值:短时间内的连接数突增情况。

4. 资源利用率(Resource Utilization)

- CPU利用率:CPU处理任务的时间占比(长期高于80%可能成为瓶颈)。

- 内存利用率:内存使用量与总容量的比例(需避免频繁GC或swap)。

- 磁盘I/O:磁盘读写速率、队列长度(如SSD通常比HDD性能更高)。

- 网络I/O:带宽利用率、吞吐量(需匹配服务器网卡和链路带宽)。

5. 错误率(Error Rate)

- 定义:请求处理失败的比例(如HTTP 5xx错误)。

- 目标:通常需低于0.1%,高并发下需关注是否因资源不足导致错误激增。

二、性能评估工具

1. 负载测试工具

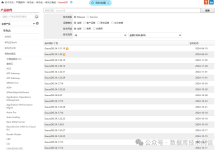

- Apache JMeter:模拟多线程并发请求,支持HTTP、FTP、数据库等协议,生成详细性能报告。

- LoadRunner:企业级负载测试工具,支持复杂场景建模和实时监控。

- wrk:轻量级HTTP压测工具,基于多线程和异步I/O,适合高并发场景。

- GoReplay:实时捕获线上流量并回放,用于模拟真实用户行为。

2. 监控工具

- 服务器层面:

- Prometheus + Grafana:开源监控套件,采集CPU、内存、磁盘等指标,支持自定义仪表盘。

- Nmon/htop:命令行工具,实时查看服务器资源使用情况。

- 应用层面:

- New Relic/Datadog:APM(应用性能监控)工具,追踪请求链路、定位慢查询和代码瓶颈。

- ELK Stack:日志分析工具(Elasticsearch+Logstash+Kibana),用于排查错误日志。

3. 基准测试工具

- ab(Apache Benchmark):简单的HTTP压测工具,适合快速测试基本性能。

- Siege:支持并发和持续负载测试,生成吞吐量和响应时间统计。

三、影响性能的关键因素

1. 硬件与基础设施

- 服务器配置:CPU核心数、内存容量、磁盘类型(SSD/NVMe)、网卡速率(1G/10G)。

- 网络环境:带宽瓶颈、延迟(如跨机房请求需考虑RTT)、CDN缓存命中率。

2. 软件与架构

- Web服务器软件:Nginx(高性能反向代理)、Apache(功能全面但资源消耗较高)、Node.js(异步I/O适合高并发)。

- 应用逻辑:低效的数据库查询(如未命中索引)、复杂业务逻辑阻塞主线程、序列化/反序列化开销。

- 缓存策略:是否使用Redis/Memcached缓存静态数据或热点数据,减少数据库压力。

- 架构设计:单节点 vs 分布式架构、负载均衡策略(轮询/最少连接/IP哈希)、是否支持水平扩展。

3. 代码与优化

- 编程语言性能:Go/Java等编译型语言通常比Python/PHP更快。

- 代码效率:循环嵌套过深、内存泄漏、锁竞争(如多线程场景)。

- 异步与并发:是否充分利用异步IO、线程池或协程处理并发请求。

四、性能评估流程

- 明确测试场景(如峰值流量、日常负载)、预期指标(如支持1000并发、响应时间≤1s)。

- 模拟生产环境配置(硬件、网络、数据量),避免因环境差异导致结果失真。

- 逐步增加并发量(如从100到10000),观察吞吐量、响应时间和资源利用率的变化趋势。

- 记录“拐点”(如吞吐量不再增长或错误率突增时的并发数)。

- 通过监控工具定位瓶颈(如CPU满载、数据库慢查询、网络带宽不足)。

- 使用火焰图(Flame Graph)或调用链分析(如OpenTelemetry)定位代码层面的性能问题。

- 根据瓶颈调整配置(如增加服务器节点、优化SQL语句),重新测试验证效果。

五、性能优化方向

1. 硬件与基础设施优化

- 升级服务器配置(如增加CPU核心、更换SSD)。

- 采用CDN加速静态资源(图片、CSS、JS),减少源站压力。

- 部署负载均衡器(如Nginx/LVS)实现流量分发,避免单节点过载。

2. 软件与架构优化

- 选择高性能Web服务器(如Nginx用于静态资源,Tomcat/Node.js用于动态逻辑)。

- 引入缓存层:

- 前端缓存:浏览器缓存、Service Worker。

- 后端缓存:Redis存储热点数据(如用户信息、商品列表)。

- 数据库优化:

- 索引优化:为高频查询字段添加索引。

- 读写分离:主从架构分担查询压力。

- 分库分表:解决单库数据量过大问题。

3. 代码与算法优化

- 减少阻塞操作:使用异步框架(如Node.js、Python的asyncio)处理I/O密集型任务。

- 优化序列化方式:使用Protobuf/JSON-B替代XML/JSON,减少数据传输体积。

- 避免重复计算:缓存中间结果(如使用 memoization 技术)。

六、典型性能评估案例

- 场景:评估电商网站在“双11”大促期间的服务器性能。

- 测试步骤:

- 使用JMeter模拟10万用户同时访问商品详情页,持续30分钟。

- 通过Prometheus监控发现:

- CPU利用率达90%,主要瓶颈在订单查询接口的数据库操作。

- 响应时间中位数从200ms上升至800ms,95%响应时间超过2s。

- 优化措施:

- 对订单表添加复合索引,减少查询耗时。

- 使用Redis缓存热门商品信息,降低数据库压力。

- 验证结果:优化后CPU利用率降至70%,响应时间中位数稳定在300ms以内。

总结

Web服务器性能评估需结合业务需求和技术架构,通过量化指标和工具定位瓶颈,从硬件、软件、代码多层面进行优化。定期评估和模拟压测(如灰度发布前的性能验证)是保障系统稳定性和用户体验的关键。

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册