links: https://lm-studio.cn/docs/api

LM Studio 可以像 Ollama 一样通过暴露本地端口实现局域网内客户端调用。以下是具体实现方式和技术细节:

1. 核心功能支持

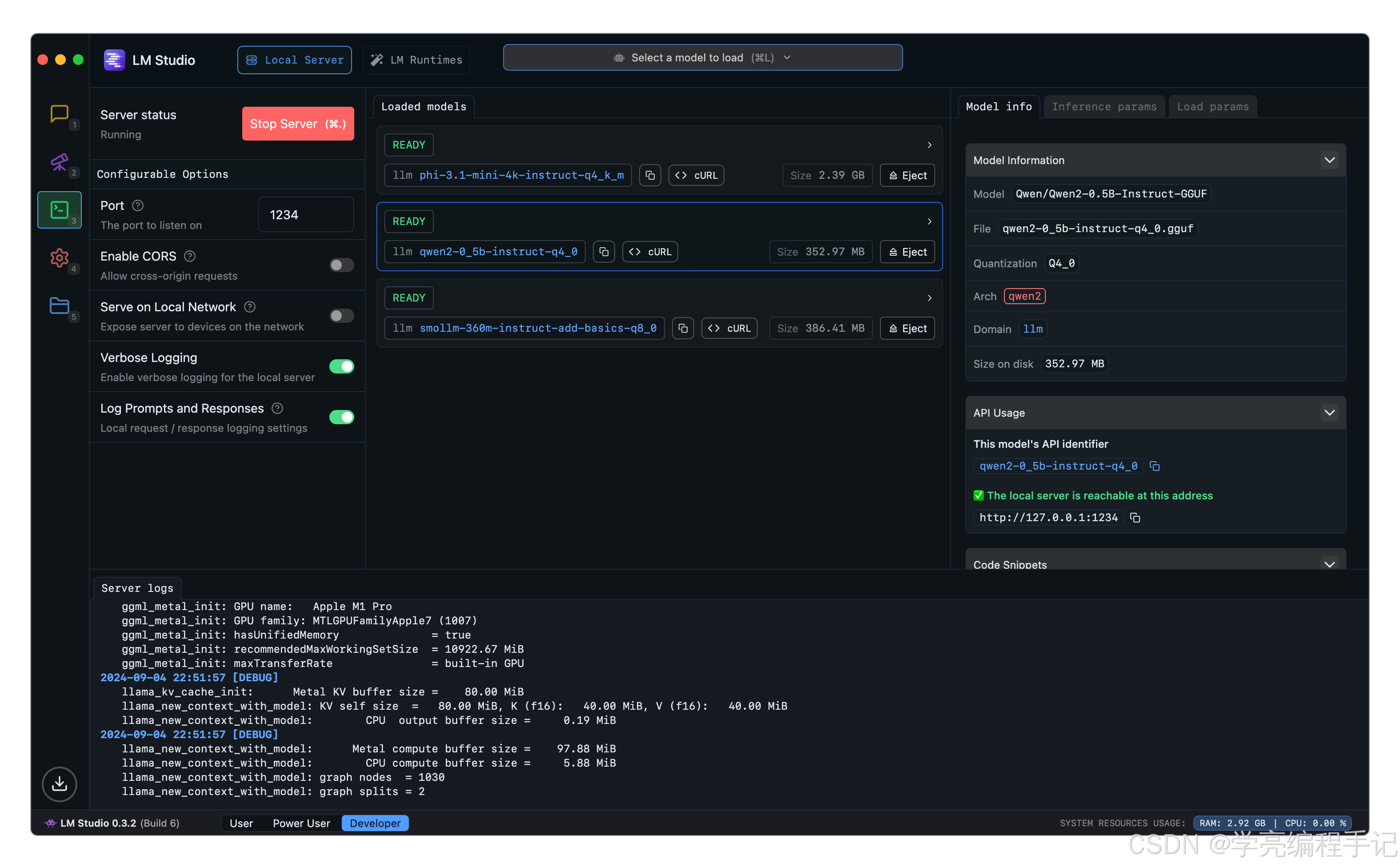

LM Studio 的 开发者选项卡 提供了完整的本地 API 服务器功能,支持以下配置:

- 端口暴露:默认使用 1234 端口,可自定义修改(需注意端口冲突问题)3

- 局域网访问:勾选 “在局域网内提供服务” 选项后,服务器会监听所有网络接口(0.0.0.0),允许其他设备通过 IP 地址访问34

- 跨域支持:启用 CORS 后,可对接网页应用或其他客户端工具3

2. 配置步骤

实现局域网调用的具体操作流程:

启动服务端:

- 在 LM Studio 的 “开发者” 选项卡中选择模型

- 勾选 “在局域网内提供服务” 并设置端口(如 1234)3

- 点击 “启动服务” 按钮,控制台会显示运行日志和访问地址(如 http://<本机IP>:1234)3

客户端调用:

- 其他设备可通过以下方式访问:# 示例:使用 curl 调用聊天接口

curl http://<本机IP>:1234/v1/chat/completions \\

-H "Content-Type: application/json" \\

-d '{"messages": [{"role": "user", "content": "你好"}], "model": "<模型名称>"}' - 支持 OpenAI 兼容的 API 格式(包括 /v1/chat/completions、/v1/completions 等端点)13

防火墙配置(Windows 系统):

- 需在防火墙入站/出站规则中开放对应端口(如 1234)5

3. 与 Ollama 的对比

| 协议兼容性 | OpenAI API 兼容 | 自有 API 格式 |

| 界面操作 | 图形界面一键配置 | 需命令行操作 |

| 多模型支持 | 需手动加载不同模型 | 支持 Modelfile 动态切换 |

| 日志管理 | 内置日志记录(可记录提示与响应)3 | 需自行配置日志工具 |

4. 典型应用场景

- 多人协作开发:团队成员通过局域网共享同一模型服务2

- 跨设备调用:手机/平板通过浏览器或 Open WebUI 访问本地模型2

- 自动化流程:对接 VS Code 插件或其他 AI 工具链1

注意:如果遇到连接问题,需检查以下三点:

网硕互联帮助中心

网硕互联帮助中心

评论前必须登录!

注册