如何在本机或服务器上部署运行DeepSeek R1模型

文章浏览阅读1.9k次,点赞7次,收藏11次。如何在服务器上部署运行DeepSeek R1模型_服务器部署deepseek

文章浏览阅读1.9k次,点赞7次,收藏11次。如何在服务器上部署运行DeepSeek R1模型_服务器部署deepseek

文章浏览阅读1.2k次,点赞18次,收藏14次。从上个月20号DeepSeek推出R1推理模型以来,DeepSeek一直频繁刷圈,一方面是来自行内行外的各个用户...

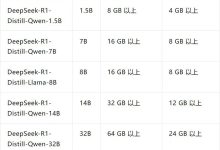

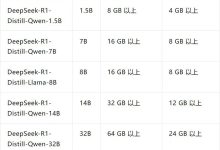

文章浏览阅读5.4k次。蒸馏版本本地化部署的意义在于,可以免费使用个人电脑算力进行逻辑推理。而且,蒸馏模型相对于教师模型,是一个体积缩小60% 到80%、推理速...

文章浏览阅读1.2k次,点赞27次,收藏6次。当一个Ollama服务器创建好后,除了用ollama指令来测试,还可以使用curl和python来通过网络测试Ol...

文章浏览阅读756次,点赞13次,收藏6次。执行ollama run deepseek-r1:32b就可以下载模型,下载完成出现下图这个命令行发送信息的提示就算...

文章浏览阅读3.3k次,点赞6次,收藏14次。LM Studio 可以像 Ollama 一样通过暴露本地端口实现局域网内客户端调用。_lm studio 局域网

文章浏览阅读880次,点赞6次,收藏11次。CherryStudio使用互联网调用自己的服务器ollama部署的deepseek教程._cherrystudio...